note

重新开始时,先来点开这个文档。还有黑马的这个文档,基本按照这个来的。

上面那各文档来推荐了一个B站视频,作为一个入门了解。再来系统的学习文档。

如果版本更新后,代码里有报错,来这里看看有没有对应的解决办法。

常用的3D处理库:PCL、Open3d、CGAL,区别对比教程。 对应的两个学习,偏软件工程,可做二开项目:CloudCompare、meshlab。

PCL

win下plc安装目录的bin里有可直接使用的程序:pcl_viewer.exe a_name.pcd -ps 10 # 这查看点,后面应该是把点放大(后面的-ps参数应该是可以不要的)(或者是pcl_viewerd.exe,效果好像差不多,一个有颜色,里面挺多都能打开的) 如果要查看一个pcd文件,需要把bin路径加到环境变量:下面这样临时终端添加,方便使用

set PATH=D:\program files\PCL 1.13.0\bin;D:\program files\PCL 1.13.0\3rdParty\FLANN\bin;D:\program files\PCL 1.13.0\3rdParty\Qhull\bin;D:\program files\PCL 1.13.0\3rdParty\OpenNI2\Tools;D:\program files\PCL 1.13.0\3rdParty\VTK\bin;%PATH%

pcl_viewerd.exe使用技巧:

-

基本使用

进入:

pcl_viewer xxxxx.pcd帮助:在界面中输入h,可以在控制台看到帮助信息

退出:界面中输入q

放大缩小:鼠标滚轮 或 Alt + [+/-]

平移:Shift+鼠标拖拽

旋转:Ctrl+鼠标拖拽

-

其他技巧

修改点颜色:数字1,2,3,4,5….9,重复按1可切换不同颜色方便观察

放大缩小点:放大Ctrl+Shift+加号,缩小 Ctrl+减号

保存截图:

j显示颜色尺寸:

u显示比例尺寸:

g在控制列出所有几何和颜色信息:

l -

鼠标选点打印坐标

选点模式进入:

pcl_viewer -use_point_picking bunny.pcd选择指定点:shift+鼠标左键

概述

- 点云Point Cloud是三维空间中,表达目标空间分布和目标表面特性的点的集合,点云通常可以从深度相机中直接获取,也可以从CAD等软件中生成。点云是用于表示多维点集合的数据结构,通常用于表示三维数据。 在3D点云中,这些点通常代表采样表面的X,Y和Z几何坐标。当存在颜色信息时(请参见下图),点云变为4D。

- 根据激光测量原理得到的点云,包含三维坐标信息(xyz)和激光反射强度信息(intensity),激光反射强度与仪器的激光发射能量、波长,目标的表面材质、粗糙程度、入射角相关。根据摄影测量原理得到的点云,包括三维坐标(xyz)和颜色信息(rgb)。结合两个原理的多传感器融合技术(多见于手持式三维扫描仪),能够同时得到这三种信息。

- 三维图像有以下几种表现形式:

- 深度图(描述物体与相机的距离信息);

- 几何模型(由CAD等软件生成);

- 点云模型(逆向工程设备采集生成)。

- PCL 起初是 ROS(Robot Operating System )下由来自斯坦福大学的年轻博士Radu等人维护和开发的开源项目。此外,PCL是BSD授权方式,可以进行完全免费的商业和学术应用。

- PCL(Point Cloud Library)是用于2D / 3D图像和点云处理的大型开源跨平台的C++编程库。PCL框架实现了大量点云相关的通用算法和高效的数据结构。内容涉及了点云的获取、滤波、分割、配准、检索、特征提取、特征估计,表面重建、识别、模型拟合、追踪、曲面重建、可视化等等,这些算法可用于从嘈杂的数据中过滤出异常值,将3D点云缝合在一起,分割场景的部分区域,提取关键点并计算描述符,根据物体的几何外观识别实际物体,创建表面点云并将其可视化。支持多种操作系统,可以在Windows、Linux、MacOS X、Android、部分嵌入式实时系统上运行。

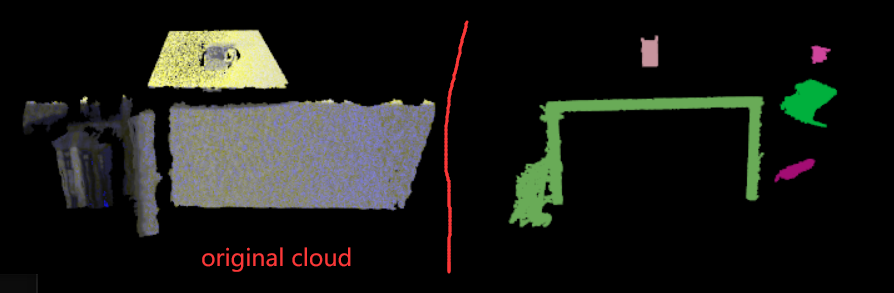

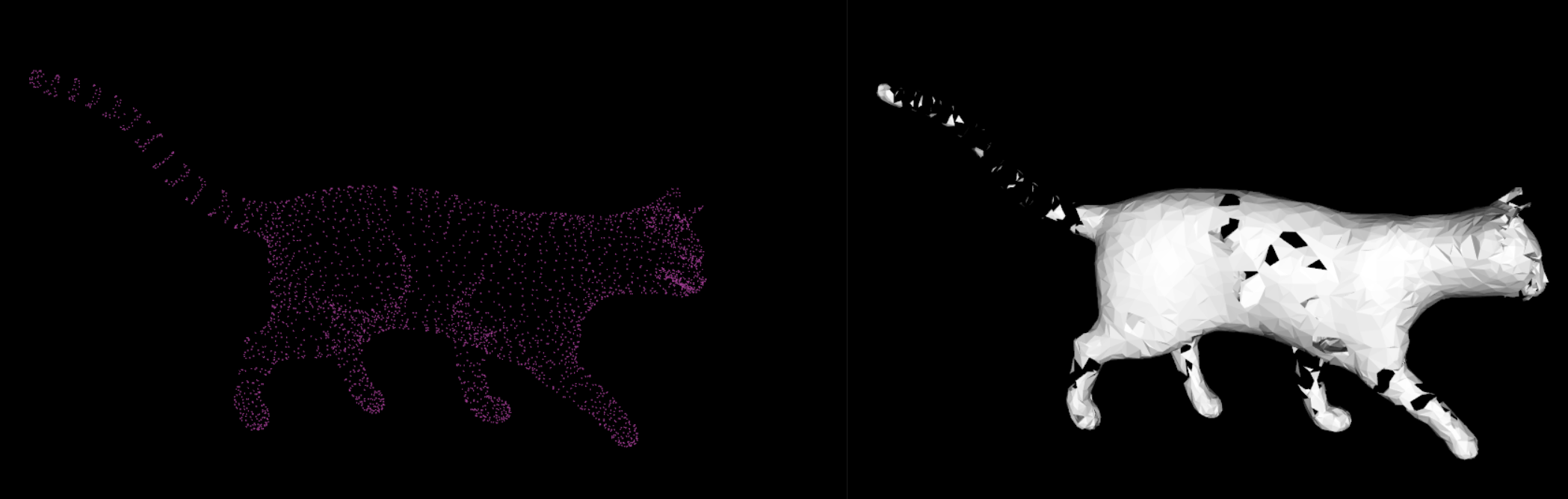

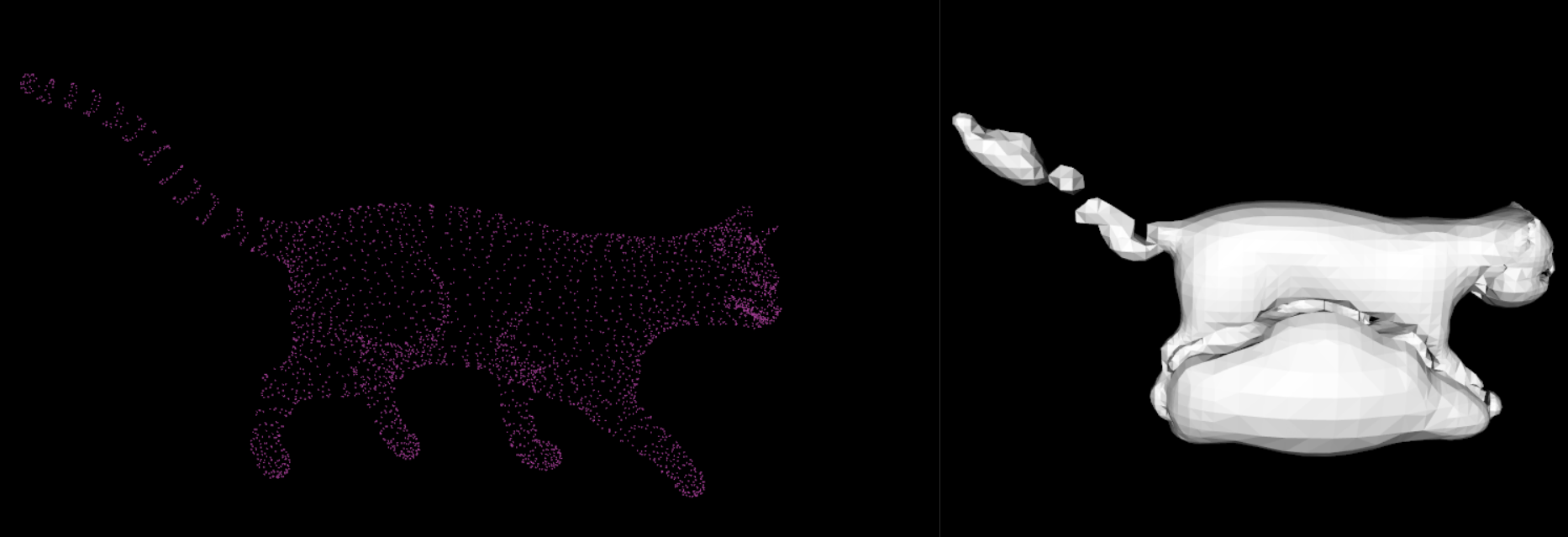

一些常见的点云图如下 :

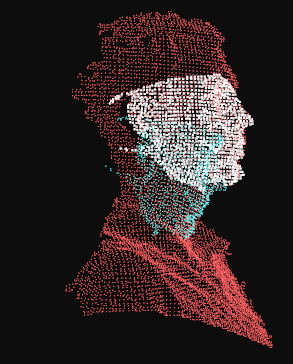

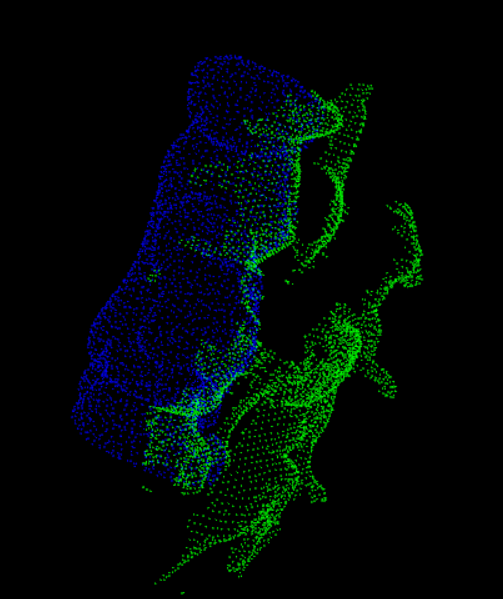

- 人的侧脸3D:

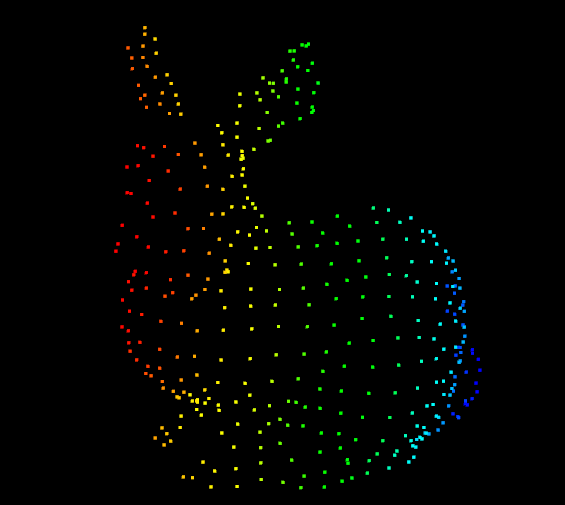

- 一只兔子3D:

- 桌子及牛奶4D:

一、安装、Demo

linux:编译安装自己去看文档(这个文档也是教程来源)吧,用到时再来完善。(别人编译笔记参考)

Windows: 在PCL的Release页面下载”PCL-1.13.0-AllInOne-msvc2022-win64.exe”(写的时候是最新版本),然后安装就好了,环境变量先不添加,后续用到时手动去。 (注:安装过程可能会弹出OpenNI2的安装,那就指定好位置。也可能不会,我这次OpenNI2是自己就安装到了这个路径 C:\Program Files\OpenNI2\,然后去到”D:\program files\PCL 1.13.0\3rdParty\OpenNI2”这里面,运行它的.msi安装文件,先卸载了,再安装到这个路径,保持统一)

main.cpp:Demo的源码,成功运行后,就可以看到一个画面,缩放一下鼠标就能看到一只兔子

==一定注意自己给的库,如果是带d的debug动态库,就一定要在debug模型下,release下就会报错==。

#include <pcl/visualization/cloud_viewer.h>

#include <iostream>

#include <pcl/io/io.h>

#include <pcl/io/pcd_io.h>

#include <vtkAutoInit.h>

VTK_MODULE_INIT(vtkInteractionStyle);

VTK_MODULE_INIT(vtkRenderingFreeType);

//VTK_MODULE_INIT(vtkRenderingOpenGL); # 教程是里这行,是错的,新的是下面这个库了,不该就会产生“无法解析的外部符号的错误”,就是因为库没被找到

VTK_MODULE_INIT(vtkRenderingOpenGL2);

int user_data;

void viewerOneOff(pcl::visualization::PCLVisualizer& viewer) {

viewer.setBackgroundColor(1.0, 0.5, 1.0);

pcl::PointXYZ o;

o.x = 1.0;

o.y = 0;

o.z = 0;

viewer.addSphere(o, 0.25, "sphere", 0);

std::cout << "i only run once" << std::endl;

}

void viewerPsycho(pcl::visualization::PCLVisualizer& viewer) {

static unsigned count = 0;

std::stringstream ss;

ss << "Once per viewer loop: " << count++;

viewer.removeShape("text", 0);

viewer.addText(ss.str(), 200, 300, "text", 0);

//FIXME: possible race condition here:

user_data++;

}

int main() {

pcl::PointCloud<pcl::PointXYZRGBA>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZRGBA>);

pcl::io::loadPCDFile(R"(C:\Users\Administrator\Downloads\rabbit.pcd)", *cloud);

pcl::visualization::CloudViewer viewer("Cloud Viewer");

//blocks until the cloud is actually rendered

viewer.showCloud(cloud);

//use the following functions to get access to the underlying more advanced/powerful

//PCLVisualizer

//This will only get called once

viewer.runOnVisualizationThreadOnce(viewerOneOff);

//This will get called once per visualization iteration

viewer.runOnVisualizationThread(viewerPsycho);

while (!viewer.wasStopped()) {

//you can also do cool processing here

//FIXME: Note that this is running in a separate thread from viewerPsycho

//and you should guard against race conditions yourself...

user_data++;

}

return 0;

}

1.1. VS的.sln

-

1.添加Path的环境变量: (配置中的调试中的环境)

PATH=D:\program files\PCL 1.13.0\bin;D:\program files\PCL 1.13.0\3rdParty\FLANN\bin;D:\program files\PCL 1.13.0\3rdParty\Qhull\bin;D:\program files\PCL 1.13.0\3rdParty\OpenNI2\Tools;D:\program files\PCL 1.13.0\3rdParty\VTK\bin

-

2.添加头文件路径:

D:\program files\PCL 1.13.0\3rdParty\Boost\include\boost-1_80 D:\program files\PCL 1.13.0\3rdParty\Eigen\eigen3 D:\program files\PCL 1.13.0\3rdParty\FLANN\include D:\program files\PCL 1.13.0\3rdParty\OpenNI2\Include D:\program files\PCL 1.13.0\3rdParty\Qhull\include D:\program files\PCL 1.13.0\3rdParty\VTK\include\vtk-9.2 D:\program files\PCL 1.13.0\include\pcl-1.13

-

3.添加库文件路径:

D:\program files\PCL 1.13.0\3rdParty\Boost\include\boost-1_80 D:\program files\PCL 1.13.0\3rdParty\Eigen\eigen3 D:\program files\PCL 1.13.0\3rdParty\FLANN\include D:\program files\PCL 1.13.0\3rdParty\OpenNI2\Include D:\program files\PCL 1.13.0\3rdParty\Qhull\include D:\program files\PCL 1.13.0\3rdParty\VTK\include\vtk-9.2 D:\program files\PCL 1.13.0\include\pcl-1.13

-

4.添加对应库文件,区分Debug/Release版本: 如果是简单获取一个文件夹下的lib名的话,可以在cmd中用命令:

dir *.lib /B库文件很多,手写不现实,用python代码获取:(看下面) -

5.添加宏定义:属性–>c/c++–>预处理器–>预处理器定义

- _CRT_SECURE_NO_WARNINGS # 好像是f_open不安全,不定义这个就会报错 _SCL_SECURE_NO_WARNINGS # 后面这两个好像不给也行 _SILENCE_FPOS_SEEKPOS_DEPRECATION_WARNING # 是为了防止出现错误erroe c4996;_Uninitialized_copy0

-

6.可能出现的错误:“功能测试宏的参数必须是简单的标识符”,解决办法: 此刻:错误列表中默认是“生成+Intellisense”,将其改成”仅生成”就ok了。

python获取lib名称

import os

def get_libs(path, release_suffix, debug_suffix, is_debug=True):

outputs = ""

# PCL的lib

files = os.listdir(path)

if is_debug:

files = [file for file in files if file.endswith(debug_suffix)]

else: # release版本要把所有的debug版本去掉

files = [file for file in files if (file.endswith(release_suffix) and not file.endswith(debug_suffix))]

output = ";".join(files)

outputs += output + ";"

return outputs

if __name__ == '__main__':

# 下面是获取PCL的lib库的,用来配置vs的环境,因为不知道要那些库,只能暂时都要了,还分debug和release版本

# 1.pcl的 # 函数默认给的debug版本,is_debug改成false就是release版本

pcl_libs = get_libs(r"D:\program files\PCL 1.13.0\lib", ".lib", "d.lib")

# 2.boost库,带有-gd-的是debug版本

boost_libs = get_libs(r"D:\program files\PCL 1.13.0\3rdParty\Boost\lib", "-x64-1_80.lib", "-gd-x64-1_80.lib")

# 3.Eign只需要头文件,没有库

# 4.FLANN

flann_libs = get_libs(r"D:\program files\PCL 1.13.0\3rdParty\FLANN\lib", ".lib", "-gd.lib")

# 5.OpenNI2

openni_lib = "OpenNI2.lib;"

# 6.Qhull

qhull_libs = get_libs(r"D:\program files\PCL 1.13.0\3rdParty\Qhull\lib", ".lib", "d.lib")

# 7.VTK

vtk_libs = get_libs(r"D:\program files\PCL 1.13.0\3rdParty\VTK\lib", ".lib", "gd.lib")

# 全部连接在一起

all_libs = pcl_libs + boost_libs + flann_libs + openni_lib + qhull_libs + vtk_libs

print(all_libs)

1.2. CMake

-

CMakeLists.txt:

cmake_minimum_required(VERSION 3.12) project(pcl_example_project) set(CMAKE_BUILD_TYPE Debug) add_compile_definitions(_CRT_SECURE_NO_WARNINGS) # 为了添加预定义宏 # 这主要是针对win上的vs的cmake用的,不然它会把build弄到C盘里 # 设置输出根目录为build/Debug set(OUTPUT_DIRECTORY_ROOT ${CMAKE_CURRENT_SOURCE_DIR}/build/${CMAKE_BUILD_TYPE}) # 设置可执行程序输出到build/Debug/bin目录 set(CMAKE_RUNTIME_OUTPUT_DIRECTORY "${OUTPUT_DIRECTORY_ROOT}/bin" CACHE PATH "Runtime directory" FORCE) # 设置库文件输出到build/Debug/lib目录 set(CMAKE_LIBRARY_OUTPUT_DIRECTORY "${OUTPUT_DIRECTORY_ROOT}/lib" CACHE PATH "Library directory" FORCE) set(CMAKE_ARCHIVE_OUTPUT_DIRECTORY "${OUTPUT_DIRECTORY_ROOT}/lib" CACHE PATH "Archive directory" FORCE) find_package(PCL REQUIRED) add_executable(demo main.cpp) # 下面这一行和add_compile_definitions的作用是一样的, # target_compile_definitions(demo PRIVATE _CRT_SECURE_NO_WARNINGS) target_link_libraries(demo ${PCL_LIBRARIES}) # 我没设置这个,发现这俩变量都能打出来 message(STATUS "root: ${PCL_ROOT}") # D:/program files/PCL 1.13.0 message(STATUS "dir: ${PCL_DIR}") # D:/program files/PCL 1.13.0/cmake -

必须去修改PCL中修改”D:\program files\PCL 1.13.0\cmake\PCLConfig.cmake”,问题就是因为Boost的原因,boost安装库的文档中我也说了,它的cmake有点问题,要手动去写头文件这些路径:

# 大概在PCLConfig.cmake文件126行左右 # find_package(Boost 1.65.0 ${QUIET_} COMPONENTS system filesystem date_time iostreams serialization) # 手动将这行注释掉 # 不要它自己find了,我们手动添加 set(Boost_INCLUDE_DIR "D:/program files/PCL 1.13.0/3rdParty/Boost/include/boost-1_80") set(Boost_LIBRARY_DIRS "D:/program files/PCL 1.13.0/3rdParty/Boost/lib") set(Boost_LIBRARIES libboost_atomic-vc143-mt-gd-x64-1_80.lib libboost_bzip2-vc143-mt-gd-x64-1_80.lib ...) # 没写完,用python代码去拿全部写进来 #set(BOOST_FOUND ${Boost_FOUND}) set(BOOST_FOUND 1) # 手动改成true set(BOOST_INCLUDE_DIRS "${Boost_INCLUDE_DIR}") set(BOOST_LIBRARY_DIRS "${Boost_LIBRARY_DIRS}") set(BOOST_LIBRARIES ${Boost_LIBRARIES}) # 手动添加boost头文件、库文件路径 include_directories(${BOOST_INCLUDE_DIRS}) link_directories(${BOOST_LIBRARY_DIRS}) -

为了能在命令行运行,如果系统环境变量中没添加这些bin目录的话,就命令行set一下:

set PATH=D:\program files\PCL 1.13.0\bin;D:\program files\PCL 1.13.0\3rdParty\FLANN\bin;D:\program files\PCL 1.13.0\3rdParty\Qhull\bin;D:\program files\PCL 1.13.0\3rdParty\OpenNI2\Tools;D:\program files\PCL 1.13.0\3rdParty\VTK\bin;%PATH%

放这,PCL官方的cmake模板:

# 安装后在CMakeLists.txt中指定PCL_DIR路径(即PCLConfig.cmake文件路径)即可:

set(PCL_DIR "/home/usr/pcl-1.9/share/pcl-1.9")

set(PCL_DIR "/home/hcq/software_ubuntu/pcl-1.11_compile/share/pcl-1.11")

find_package(PCL 1.9 REQUIRED COMPONENTS) # <<<<<<<<<<1.9

include_directories(${PCL_INCLUDE_DIRS})

link_directories(${PCL_LIBRARY_DIRS})

add_definitions(${PCL_DEFINATIONS})

add_executable (main main.cpp)

target_link_libraries (main ${PCL_LIBRARIES})

二、点云入门

2.1 PCD文件格式

一个典型的PCD文件如下:

# .PCD v.5 - Point Cloud Data file format VERSION .5 FIELDS x y z # 指定一个点的每一个维度和字段名字,例如

FIELDS x y z # XYZ data FIELDS x y z rgb # XYZ + colors FIELDS x y z normal_x normal_y normal_z # XYZ + surface normals

SIZE 4 4 4 # 指定每一个维度的字节数大小 TYPE F F F # 指定每一个维度的类型,I为int, U为uint, F则为float COUNT 1 1 1 # 指定每一个维度包含的元素数,如果没有COUNT,默认都为1 WIDTH 397 # 点云数据集的宽度 HEIGHT 1 # 点云数据集的高度 VIEWPOINT 0 0 0 1 0 0 0 # 指定点云获取的视点和角度,在不同坐标系之间转换时使用(由3个平移+4个四元数构成) POINTS 397 # 总共的点数 DATA ascii # 存储点云数据的数据类型,有ASCII和binary 0.0054216 0.11349 0.040749 -0.0017447 0.11425 0.041273 -0.010661 0.11338 0.040916 0.026422 0.11499 0.032623 0.024545 0.12284 0.024255 0.034137 0.11316 0.02507

还有除PCD以为的其它格式:

- PLY:一种多边形文件格式;

- STL:主要应用于CAD、CAM领域;

- OBJ:是从几何学上定义的文件格式。

基本类型: PCL的基本数据类型是==PointCloud==,它是一个c++模板类,包含了以下字段:

- “width(int)”: 指定点云数据集的宽度

- 对于无组织格式的数据集,width代表了所有点的总数;

- 对于有组织格式的数据集,width代表了一行中的总点数。

- “height(int)”: 指定点云数据集的高度

- 对于无组织格式的数据集,height的值为1;

- 对于有组织格式的数据集,height表示总行数。

- “points(std::vector<PointT>)”:包含所有PointT类型的点的数据列表。

衍生类型:

- PointXYZ - float x,y,z

- PointXYZI - float x,y,z,intensity

- PointXYZRGB - float x,y,z,rgb

- PointXYZRGBA - float x,y,z,uint_t rgba

- Normal - float normal[3], curvature 法线方向, 对应的曲率的测量值

- PointNormal - float x,y,z,normal[3],curvature采样点,法线和曲率

- Histogram - float histogtam[N]用于存储一般用途的n维直方图

==序列化+反序列化==(可保存成明文或是二进制的格式)

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/point_types.h>

// 序列化

void serialize() {

pcl::PointCloud<pcl::PointXYZ> cloud;

// 随机生成5个点

cloud.width = 5;

cloud.height = 1;

cloud.is_dense = false;

cloud.points.resize(cloud.width * cloud.height);

for (auto &point : cloud) {

point.x = 1024 * rand() / (RAND_MAX + 1.0f);

point.y = 1024 * rand() / (RAND_MAX + 1.0f);

point.z = 1024 * rand() / (RAND_MAX + 1.0f);

}

pcl::io::savePCDFileASCII("test_pcd.pcd", cloud); // 保存成明文

pcl::io::savePCDFileBinary("test_pcl_bin.pcd", cloud); // 保存成二进制

pcl::io::savePCDFile("123.pcd", cloud, false); // flase是存明文,true是存二进制

std::cout << "Saved" << cloud.size() << "data points to test_pcd.pcd" << std::endl;

}

// 反序列化,将点云数据加载到PointCloud对象中

void deserialize() {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>);

if (pcl::io::loadPCDFile("test_pcd", *cloud) == 1) {

PCL_ERROR("READ ERROR!"); // PCL中定义的宏

return;

}

std::cout << "Load " << cloud->width * cloud->height << "data points" << std::endl;

// 打印方式一

for (size_t i = 0; i < cloud->points.size(); ++i) {

std::cout << " " << cloud->points[i].x << " " << cloud->points.at(i).y << " " << cloud->points[i].z << std::endl;

}

// 打印方式二

for (auto &point : *cloud) {

std::cout << " " << point.x << " " << point.y << " " << point.z << std::endl;

}

}

2.2 数据可视化

还要来根据这个代码,把这里完善了。

1、采用==回调函数==的方式来设置显示的窗口:

#include <iostream>

#include <pcl/io/io.h>

#include <pcl/io/pcd_io.h>

#include <pcl/visualization/cloud_viewer.h>

int user_data;

void viewerOneOff(pcl::visualization::PCLVisualizer& viewer) {

// 设置背景色为粉红色

viewer.setBackgroundColor(1.0, 0.5, 1.0);

pcl::PointXYZ o;

o.x = 1.0;

o.y = 0;

o.z = 0;

// 添加一个圆心为o,半径为0.25m的球体

viewer.addSphere(o, 0.25, "sphere", 0);

std::cout << "I only run once" << std::endl;

}

void viewerPsycho(pcl::visualization::PCLVisualizer& viewer) {

static unsigned count = 0;

std::stringstream ss;

ss << "Once per viewer loop: " << count++;

// 每次刷新时,移除text,添加新的text

viewer.removeShape("text", 0);

viewer.addText(ss.str(), 200, 300, "text", 0);

//FIXME: possible race condition here:

user_data++;

}

int main(int argc, char **argv) {

// 创建点云的智能指针

pcl::PointCloud<pcl::PointXYZRGBA>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZRGBA>);

// 加载pcd

pcl::io::loadPCDFile("rabbit.pcd", *cloud);

pcl::visualization::CloudViewer viewer("Cloud Viewer");

// 这会一直阻塞,直到点云被渲染

viewer.showCloud(cloud);

// 只会调用一次,(非必须)

viewer.runOnVisualizationThreadOnce(viewerOneOff);

// 每次可视化迭代都会调用一次(频繁调用) (非必须)

viewer.runOnVisualizationThread(viewerPsycho);

// 一直循环,直到按q退出

while (!viewer.wasStopped()) {

// 这里就可以对点云做很多处理

user_data++;

}

return 0;

}

2、直接去设置格式做显示:

#include <iostream>

#include <pcl/io/io.h>

#include <pcl/io/pcd_io.h>

#include <pcl/visualization/cloud_viewer.h>

int main(int argc, char **argv) {

// 点云数据指针

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>);

pcl::io::loadPCDFile("rabbit.pcd", *cloud);

// 创建PCLVisualizer

boost::shared_ptr<pcl::visualization::PCLVisualizer> viewer(new pcl::visualization::PCLVisualizer("3D Viewer"));

// 设置背景为灰色(非必须)

viewer->setBackgroundColor(0.05, 0.05, 0.05, 0);

// 添加一个普通点云(可以指定颜色,也可以去掉single_color参数不设置)

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> single_color(cloud, 0, 255, 255); // 指点点云颜色

viewer->addPointCloud<pcl::PointXYZ>(cloud, single_color, "sample cloud");

viewer->setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 3, "sample cloud");

// 添加一个0.5倍缩放的坐标系(非必须)

viewer->addCoordinateSystem(0.5);

// 按q退出

while (!viewer->wasStopped()) {

// 每次循环调用内部的重绘函数

viewer->spinOnce();

}

return 0;

}

2.3 common模块

主要是包含了PCL库常用的公共数据结构和方法,比如PointCloud的类和许多用于表示点,曲面,法向量,特征描述等点的类型,用于计算距离,均值以及协方差,角度转换以及几何变化的函数。

使用,如:#include <pcl/common/angles.h>

common模块中的头文件:

- angles.h:定义了标准的C接口的角度计算函数;

- centriod.h:定义了中心点的估算以及协方差矩阵的计算;

- commo.h:标准的C以及C++类,是其他common 函数的父类;

- distance.h:定义标准的C接口用于计算距离;

- file_io.h:定义了一些文件帮助写或者读方面的功能;

- random.h:定义一些随机点云生成的函数;

- geometry:定义一些基本的几何功能的函数;

- intersection.h:定义线与线相交的函数;

- norm.h:定义了标准的C方法计算矩阵的正则化;

- time.h:定义了时间计算的函数;

- Point_types.h:定义了所有PCL实现的点云的数据结构的类型。

common模块的基本函数:(不同函数要注意导入上面对应的头文件才有)更细的看这、这。

- 从弧度到角度:pcl::rad2deg(float alpha):

- 从角度到弧度:pcl::deg2rad(float alpha):

- 正则化角度在(-PI,PI)之间:pcl::normAngle(float alpha):

- 计算给定一群点的3D中心点,并且返回一个三维向量: pcl::compute3DCentroid (const pcl::PointCloud< PointT > &cloud, Eigen::Matrix< Scalar, 4, 1 > ¢roid)

- 计算给定的三维点云的协方差矩阵: pcl::computeCovarianceMatrix (const pcl::PointCloud< PointT > &cloud, const Eigen::Matrix< Scalar, 4, 1 > ¢roid, Eigen::Matrix< Scalar, 3, 3 > &covariance_matrix)

- 计算正则化的3*3的协方差矩阵以及给定点云数据的中心点: pcl::computeMeanAndCovarianceMatrix (const pcl::PointCloud< PointT > &cloud, Eigen::Matrix< Scalar, 3, 3 > &covariance_matrix, Eigen::Matrix< Scalar, 4, 1 > ¢roid

- 计算两个向量之间的角度: pcl::getAngle3D (const Eigen::Vector4f &v1, const Eigen::Vector4f &v2, const bool in_degree=false)

- 同时计算给定点云数据的均值和标准方差: pcl::getMeanStd (const std::vector< float > &values, double &mean, double &stddev)

- 在给定边界的情况下,获取一组位于框中的点: pcl::getPointsInBox (const pcl::PointCloud< PointT > &cloud, Eigen::Vector4f &min_pt, Eigen::Vector4f &max_pt, std::vector< int > &indices)

- 给定点云数据中点与点之间的最大距离的值: pcl::getMaxDistance (const pcl::PointCloud< PointT > &cloud, const Eigen::Vector4f &pivot_pt, Eigen::Vector4f &max_pt)

- 获取点直方图上的最小值和最大值: pcl::getMinMax (const PointT &histogram, int len, float &min_p, float &max_p)

- 根据给定的多边形的点云计算多边形的面积: pcl::calculatePolygonArea (const pcl::PointCloud< PointT > &polygon)

- 获取点到线的平方距离(由点和方向表示): pcl::sqrPointToLineDistance (const Eigen::Vector4f &pt, const Eigen::Vector4f &line_pt, const Eigen::Vector4f &line_dir)

- 确定最小特征值及其对应的特征向量: pcl::eigen22 (const Matrix &mat, typename Matrix::Scalar &eigenvalue, Vector &eigenvector)

- 计算3x3矩阵的行列式: pcl::determinant3x3Matrix (const Matrix &matrix)

- 计算2x2矩阵的逆: pcl::invert2x2 (const Matrix &matrix, Matrix &inverse)

- 从给定的变换矩阵中提取欧拉角: pcl::getEulerAngles (const Eigen::Transform< Scalar, 3, Eigen::Affine > &t, Scalar &roll, Scalar &pitch, Scalar &yaw)

2.3.1 矩阵变换

如果是传参的方式,传递pcd或ply文件,可以参考这个代码。PCL有对参数的解析代码。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/io/ply_io.h>

#include <pcl/point_cloud.h>

#include <pcl/common/transforms.h> // 要这个头文件

#include <pcl/visualization/pcl_visualizer.h>

int main(int argc, char **argv) {

pcl::PointCloud<pcl::PointXYZ>::Ptr source_cloud(new pcl::PointCloud<pcl::PointXYZ>());

if (pcl::io::loadPCDFile("rabbit.pcd", *source_cloud) < 0) {

std::cout << "Error loading point cloud file!" << std::endl;

return -1;

}

// 方式一:使用 Matrix4f

Eigen::Matrix4f transform_1 = Eigen::Matrix4f::Identity();

// 定义一个旋转矩阵(see https://en.wikipedia.org/wiki/Rotation_matrix)

float theta = M_PI / 4; // 旋转角度,注意是弧度制

transform_1(0, 0) = cos(theta);

transform_1(0, 1) = -sin(theta);

transform_1(1, 0) = sin(theta);

transform_1(1, 1) = cos(theta);

transform_1(0, 3) = 2.5; // 在x轴上定义一个2.5m的偏移

std::cout << transform_1 << "\n\n" << std::endl; // 可直接打印

// 方式二:使用 Affine3f

Eigen::Affine3f transform_2 = Eigen::Affine3f::Identity();

transform_2.translation() << 0.8, 0.0, 0.0; // 在x轴偏移0.8m

// 绕Z轴先转45度(逆时针)

transform_2.rotate(Eigen::AngleAxisf(theta, Eigen::Vector3f::UnitZ()));

// 还可以缩放

transform_2.scale(0.5); // 缩小一倍

std::cout << transform_2.matrix() << "\n\n" << std::endl;

// 定义变化后的点云指针并执行变换得到变换后数据

pcl::PointCloud<pcl::PointXYZ>::Ptr transformed_cloud(new pcl::PointCloud<pcl::PointXYZ>());

// transform_2也是一样的,需要<pcl/common/transforms.h>头文件

pcl::transformPointCloud(*source_cloud, *transformed_cloud, transform_1);

// 可视化

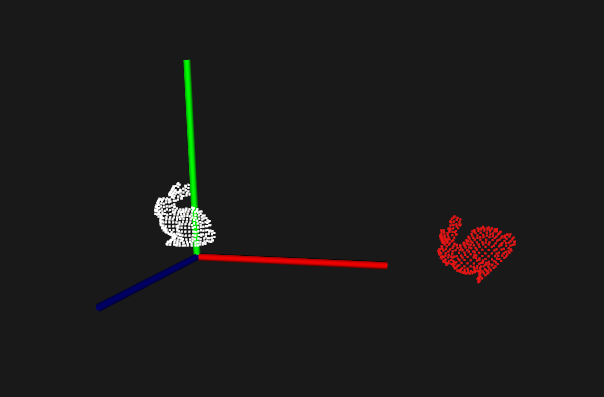

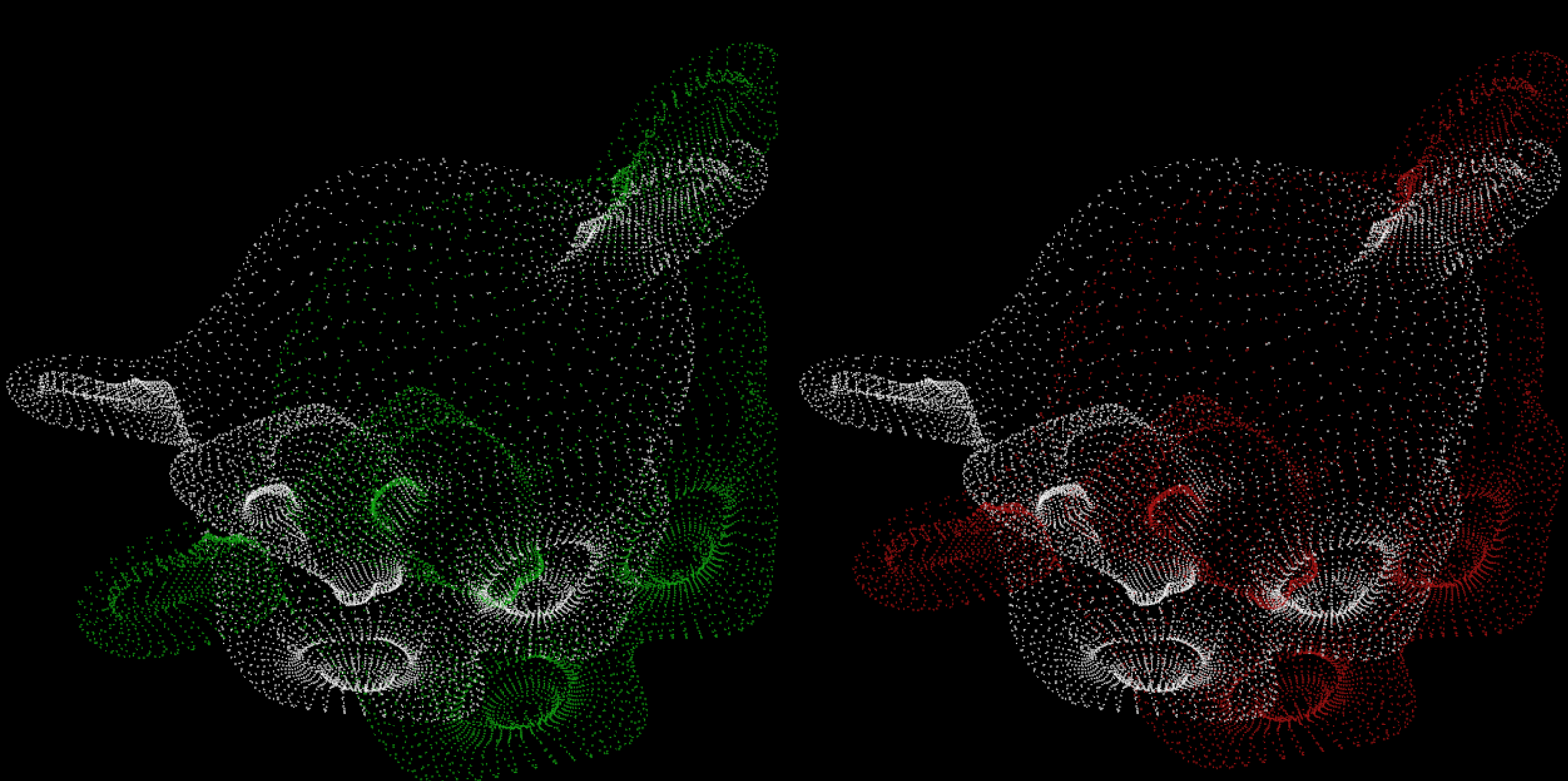

std::cout << "白色:原始点云\n" << "红色:变换后的点云" << std::endl;

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> source_cloud_color_handler(source_cloud, 255, 255, 255); // 定义初始点云颜色

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> transformed_cloud_color_handler(transformed_cloud, 255, 0, 0); // 定义变换后点云颜色

pcl::visualization::PCLVisualizer viewer("Matrix transformation example");

// 把点云添加进可视窗口,并把颜色传递进去

viewer.addPointCloud(source_cloud, source_cloud_color_handler, "original_cloud");

viewer.addPointCloud(transformed_cloud, transformed_cloud_color_handler, "transformed_cloud");

// 设置坐标系系统

viewer.addCoordinateSystem(0.5, "cloud", 0);

// 设置背景颜色(黑灰色)

viewer.setBackgroundColor(0.05, 0.05, 0.05, 0);

// 设置渲染属性(点大小)

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 2, "original_cloud");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 2, "transformed_cloud"); // 注意后面这个名字跟上面46行的保持一致

// 设置可是窗口位置(非必须)

viewer.setPosition(800, 400);

// 一直循环,直到按q退出

while (!viewer.wasStopped()) {

viewer.spinOnce();

}

return 0;

}

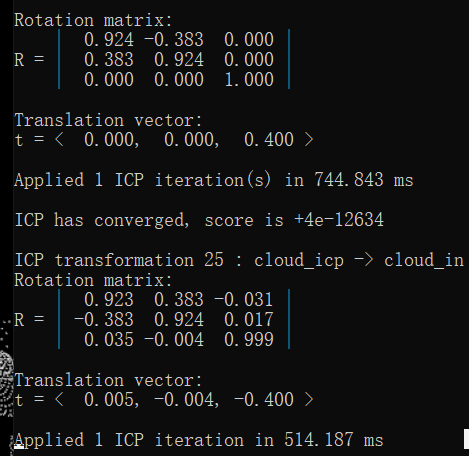

结果:

2.4 KdTree

概述:一般通过3D相机(雷达、激光扫描、立体相机)获取到的点云,一般数据量较大,分布不均匀,就要对这些离散的点之间建立拓扑关系,包括BSP树,k-d tree、KDB tree、R tree、CELL tree、八叉树等,从而实现点云的将采样、计算特征向量、点云匹配、点云拆分等功能。

索引结构中相似性查询有两种基本的方式:一种是范围查询(range searches),另一种是K近邻查询(K-neighbor searches)。范围查询就是给定查询点和查询距离的阈值,从数据集中找出所有与查询点距离小于阈值的数据;K近邻查询是给定查询点及正整数K,从数据集中找到距离查询点最近的K个数据,当K=1时,就是最近邻查询(nearest neighbor searches)。

k-d tree( k-dimensional tree):主要是==范围搜索==和==最近邻居搜索==。更细的原理看这里。

pcl::search::KdTree<PointT>是pcl::search::Search< PointT >的子类,是pcl::KdTree<PointT>的包装类。包含(1) k 近邻搜索;(2) 邻域半径搜索。

下面是KdTree的两种搜索方式的代码实现:

#include <iostream>

#include <vector>

#include <ctime>

#include <random>

#include <pcl/point_cloud.h>

#include <pcl/kdtree/kdtree_flann.h>

#include <pcl/visualization/pcl_visualizer.h>

int main(int argc, char **argv) {

// 用系统时间初始化随机种子

std::srand((unsigned int)time(NULL));

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

// 生成1000个点云数据 (也可以读取一个pcd文件,作为现成的点云数据来使用)

cloud->width = 1000;

cloud->height = 1; // height为1代表无序点云,前面数据格式介绍过

cloud->points.resize(cloud->width * cloud->height);

// 给点云填充数据 0 - 1023

std::uniform_int_distribution<unsigned> u(0, 102300);

std::default_random_engine e;

for (auto &point : cloud->points) {

//point.x = 1024.0f * rand() / (RAND_MAX + 1.0f);

point.x = static_cast<float>(u(e)) / 100.0f;

point.y = 1024.0f * rand() / (RAND_MAX + 1.0f);

point.z = 1024.0f * rand() / (RAND_MAX + 1.0f);

}

//for (auto &point : cloud->points) {

// std::cout << point.x << " " << point.y << " " << point.z << std::endl;

//}

// 创建KdTree的实现类KdTreeFLANN

pcl::KdTreeFLANN<pcl::PointXYZ> kdtree;

//pcl::search::KdTree<pcl::PointXYZ> kdtree; // 一个意思,需要<pcl/search/kdtree.h>头文件,或许也还要<pcl/search/impl/search.hpp>

// 设置搜索空间,把cloud作为输入

kdtree.setInputCloud(cloud);

// 初始化一个随机的点,作为查询点

pcl::PointXYZ searchPoint;

searchPoint.x = 1024.0f * rand() / (RAND_MAX + 1.0f);

searchPoint.y = 1024.0f * rand() / (RAND_MAX + 1.0f);

searchPoint.z = 1024.0f * rand() / (RAND_MAX + 1.0f);

// 方式一:搜索K个最近邻居

int K = 10; // 表示搜索10个临近点

std::vector<int> pointIdxNKNSearch(K); // 保存搜索到的临近点的索引

std::vector<float> pointNKNSquareDistance(K); // 保存对应临近点的距离的平方

// 返回大于了0个近邻,就将其打印出来

if (kdtree.nearestKSearch(searchPoint, K, pointIdxNKNSearch, pointNKNSquareDistance) > 0) {

for (size_t i = 0; i < pointIdxNKNSearch.size(); ++i) {

int idx = pointIdxNKNSearch.at(i);

auto &points = cloud->points;

std::cout << " " << points.at(idx).x << " " << points[idx].y << " " << points[idx].z << " (距离平方: " << pointNKNSquareDistance.at(i) << ")" << std::endl;

}

}

std::cout << "\nhello\n" << std::endl;

// 方式二:通过指定半径搜索

std::vector<int> pointIxdRadiusSearch;

std::vector<float> pointRadiusSquareDistance;

float radius = 256.0f; // 半径过小后,可能找不到的。

// 这里的返回值是一个整型,就代表找到的个数。

if (kdtree.radiusSearch(searchPoint, radius, pointIxdRadiusSearch, pointRadiusSquareDistance) > 0) {

for (size_t i = 0; i < pointIxdRadiusSearch.size(); ++i) {

int idx = pointIxdRadiusSearch.at(i);

auto &points = cloud->points;

std::cout << " " << points[idx].x << " " << points[idx].y << " " << points[idx].z << " (距离平方: " << pointRadiusSquareDistance[i] << std::endl;

}

}

pcl::visualization::PCLVisualizer viewer("PCLViewer");

viewer.setBackgroundColor(0.0, 0.0, 0.5);

viewer.addPointCloud<pcl::PointXYZ>(cloud, "cloud");

pcl::PointXYZ originalPoint(0.0, 0.0, 0.0);

// 添加从原点到搜索点的线段(后面是指定颜色,可以不要)

viewer.addLine(originalPoint, searchPoint, 0.9, 0.9, 0.0);

// 添加一个以搜索点为圆心,搜索半径为半径的球体 (颜色参数也可以不要)

viewer.addSphere(searchPoint, radius, 0.0, 0.5, 0.0, "sphere", 0);

// 添加一个放大200倍后的坐标系 (因为点的坐标值都太大了(上面随机数是0~1023),所以放大看)

viewer.addCoordinateSystem(200);

// 按q退出,这三行也等同于 viewer.spin();

while (!viewer.wasStopped()) {

viewer.spinOnce();

}

return 0;

}

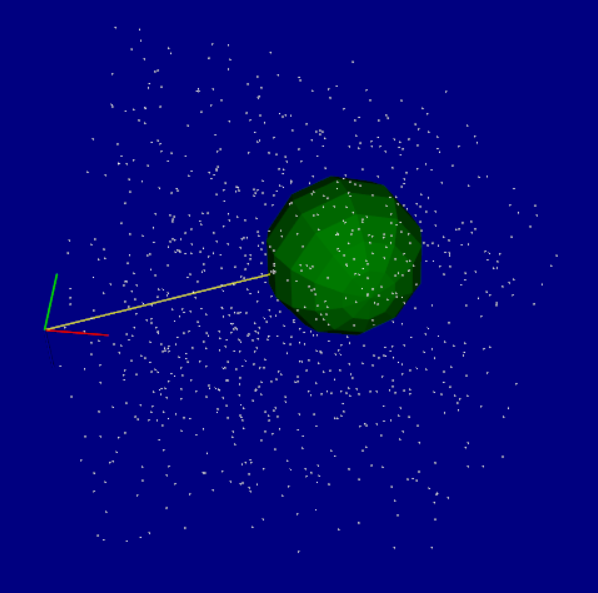

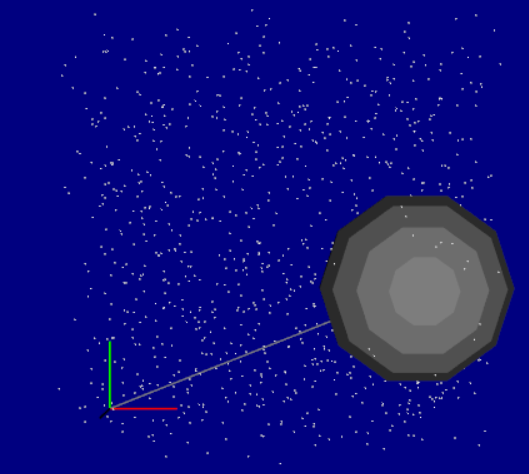

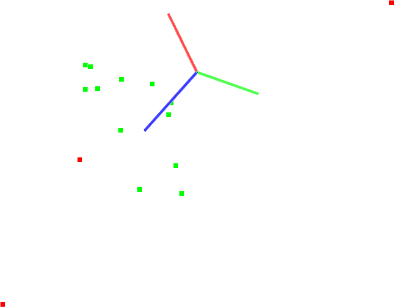

效果:

2.5 Octree(八叉树)

点云压缩:

这一点似乎跟八叉树关系不大, 但这个教程里面写到这里来了,就放这里吧。

PCL 提供了点云的压缩功能,它允许编码压缩所有类型的点云。

OpenNI 2.0 API(应用程序编程接口)提供了访问PrimerSense的兼容深度传感器。这就使得一个应用程序能够初始化传感器和从设备接收深度(depth),彩图(RGB)和红外(IR)视频流,还提供了一个统一的接口给传感器和通过深度传感器创建.oni记录文件。

OpenNI也提供了第三方中间件开发者可以相互使用深度传感器的统一接口。应用程序还能用第三方中间件(如NITE2),也可以使用直接由OpenNI提供的基础的深度和视频数据。

注意:因为它的代码没有跑通,所以就先不放这里了。

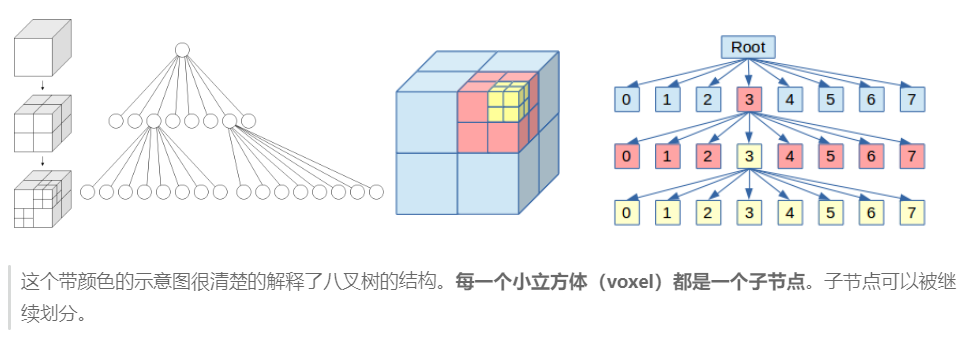

八叉树(Octree)是一种用于描述三维空间的树状数据结构。八叉树的每个节点表示一个正方体的体积元素,每个节点有八个子节点,这八个子节点所表示的体积元素加在一起就等于父节点的体积。

- 一般中心点作为节点的分叉中心。

- 八叉树若不为空树的话,树中任一节点的子节点恰好只会有八个,或零个,也就是子节点不会有0与8以外的数目。

- 分割一直要进行到节点所对应的立方体或是完全空白,或是完全为V占据,或是其大小已是预先定义的体素大小,并且对它与V之交作一定的“舍入”,使体素或认为是空白的,或认为是V占据的。

注:这里引入了一个概念:Voxel翻译为体积元素,简称体素。描述了一个预设的最小单位的正方体

三种搜索方式:

- 体素近邻搜索;

- K近邻搜索;

- 半径内近邻搜索。

#include <iostream>

#include <vector>

#include <ctime>

#include <pcl/point_cloud.h> // 点云头文件

#include <pcl/octree/octree.h> // 八叉树头文件

#include <pcl/visualization/cloud_viewer.h> // 可视化头文件

#define PRINT_POINT_DISTANCE( point, distance ) \

std::cout << "(" << point.x << ", "<< point.y << ", " << point.z << ")." \

<< " squared distance: " << distance << std::endl

#define PRINT_POINT( point ) \

std::cout << "(" << point.x << ", "<< point.y << ", " << point.z << ")" << std::endl

int main(int argc, char* argv[]) {

std::srand((unsigned int)time(NULL)); // 用系统时间初始化随机种子

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>);

// 创建点云数据

cloud->width = 1000;

cloud->height = 1; // 无序

cloud->points.resize(cloud->height * cloud->width);

// 随机循环产生点云的坐标值(产生0-1023的随机值,上面有写到过,用的是for循环)

// 它本质就是一个STL容器,可以用pcl::PointCloud<pcl::PointXYZ>::iterator iter = cloud->begin()进行循环

for(auto &point : cloud->points) {

point.x = 1024.0f * rand() / (RAND_MAX + 1.0f);

point.y = 1024.0f * rand() / (RAND_MAX + 1.0f);

point.z = 1024.0f * rand() / (RAND_MAX + 1.0f);

}

/*

创建一个octree实例,用设置分辨率进行初始化,该octree用它的页结点存放点索引向量,

分辨率参数描述最低一级octree的最小体素的尺寸,因此octree的深度是分辨率和点云空间维度的函数,

如果知道点云的边界框,应该用defineBoundingbox方法把它分配给octree然后通过点云指针把所有点增加到octree中。

*/

// 该参数描述了octree叶子leaf节点的最小体素尺寸

float resolution = 128.0; // 设置分辨率为128

pcl::octree::OctreePointCloudSearch<pcl::PointXYZ> octree(resolution);

// 设置输入点云

octree.setInputCloud(cloud); // 这两句是最关键的建立PointCloud和octree之间的联系

octree.addPointsFromInputCloud(); // 构建octree

pcl::PointXYZ searchPoint; // 设置搜索点

searchPoint.x = 1024.f * rand() / (RAND_MAX + 1.0f);

searchPoint.y = 1024.f * rand() / (RAND_MAX + 1.0f);

searchPoint.z = 1024.f * rand() / (RAND_MAX + 1.0f);

//pcl::PointXYZ searchPoint = cloud->points.at(10);

/* Neighbors within voxel search

方式一:“体素近邻搜索”,它把查询点所在的体素中其它点的索引作为查询结果返回,

结果以点索引向量的形式保存,因此搜索点和搜索结果之间的距离取决于八叉树的分辨率参数

*/

std::vector<int> pointIdxVec;

if (octree.voxelSearch(searchPoint, pointIdxVec)) {

std::cout << "Neighbors within voxel search at ";

PRINT_POINT(searchPoint);

std::vector<int>::const_iterator iter = pointIdxVec.cbegin();

for (; iter != pointIdxVec.cend(); ++iter) {

std::cout << " ";

PRINT_POINT(cloud->points.at(*iter));

}

}

std::cout << pointIdxVec.size() << std::endl;

/* K nearest neighbor search

方式二:K近邻搜索,本例中k设为10,这会把搜索结果写到两个分开的向量中

*/

int K = 10;

std::vector<int> pointIdxNKNSearch; // 包含搜索结果,即结果点的索引的向量

std::vector<float> pointNKNSquareDistance; // 保存相应的搜索点和近邻之间的距离平方

if (octree.nearestKSearch(searchPoint,K, pointIdxNKNSearch, pointNKNSquareDistance) > 0) {

std::cout << "\nK nearest neighbor search at ";

PRINT_POINT(searchPoint);

for (size_t i = 0; i < pointIdxNKNSearch.size(); ++i) {

PRINT_POINT_DISTANCE(cloud->points.at(pointIdxNKNSearch[i]), pointNKNSquareDistance.at(i));

}

}

/* Neighbors within radius search

方式三:半径内近邻搜索,和方式二类似

*/

std::vector<int> pointIdxRadiusSearch;

std::vector<float> pointRadiusSquareDistance;

float radius = 256.0f * rand() / (RAND_MAX + 1.0f);

if (octree.radiusSearch(searchPoint, radius, pointIdxRadiusSearch, pointRadiusSquareDistance) > 0) {

std::cout << "\nNeighbors within radius search at ";

PRINT_POINT(searchPoint);

std::cout << "radius: " << radius;

for (size_t i = 0; i < pointIdxRadiusSearch.size(); ++i) {

PRINT_POINT_DISTANCE(cloud->points.at(pointIdxRadiusSearch.at(i)), pointRadiusSquareDistance[i]); // 宏:打印

}

}

pcl::visualization::PCLVisualizer viewer("PCL Viewer");

viewer.setBackgroundColor(0.0, 0.0, 0.5);

viewer.addPointCloud<pcl::PointXYZ>(cloud, "cloud");

pcl::PointXYZ originPoint(0.0, 0.0, 0.0);

viewer.addLine(originPoint, searchPoint); // 添加原点到搜索点的线

viewer.addSphere(searchPoint, radius, "sphere", 0); // 添加一个球

viewer.addCoordinateSystem(200); // 添加一个放到200倍后的坐标系

while (!viewer.wasStopped()) {

viewer.spinOnce();

}

return 0;

}

效果:(每次结果不尽相同,因为很多参数是每次随机的)

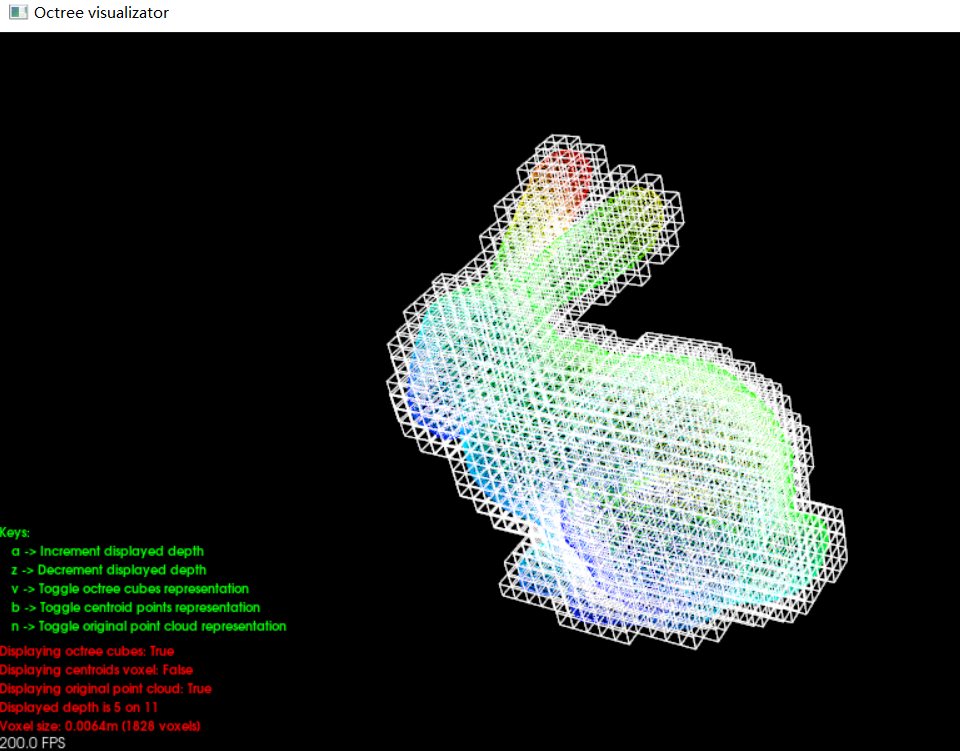

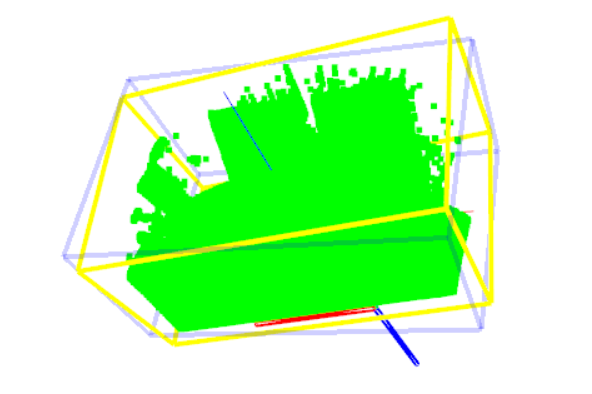

此外,PCL的bin路径下,有对应查看octree的exe,名为pcl_octree_viewer.exe,使用方式:

pcl_octree_viewer.exe <pcd file> <resolution>。如:pcl_octree_viewer.exe rabbit.pcd 0.0001

效果:

翻译这个界面的按钮名字:

- a -> 增加显示深度(减小体素大小)

- z -> 降低显示深度(增加体素大小)

- v -> 隐藏或显示octree立方体

- b -> 隐藏或显示体素中心点

- n -> 隐藏或显示原始点云

- q -> 退出

三、点云进阶

学习目标

- 能够进行点云滤波Filtering

- 能够使用直通滤波PassThrough处理点云

- 能够对点云进行降采样DownSampling

- 能够独立使用工具进行降采样

- 能够能够从点云创建深度图;

- 能够从深度图中提取边界;

- 能够理解关键点的概念和算法;

- 能够理解采样一致性算法RANSAC;

- 能够说出特征描述与提取的作用

- 能够理解特征点;

- 能够进行表面法向量估算;

- 能够提取点云的PFH描述子。

3.1 点云滤波Filtering

应用场景:

- 点云数据密度不规则需要平滑处理;

- 去除因为遮挡等问题造成离群点

- 数据量较大,需要进行下采样(DownSample)

- 去除噪声数据。

PCL点云格式分为有序点云和无序点云:

- 针对有序点云提供了:双边滤波、高斯滤波、中值滤波等;

- 针对无序点云提供了:体素栅格、随机采样等。

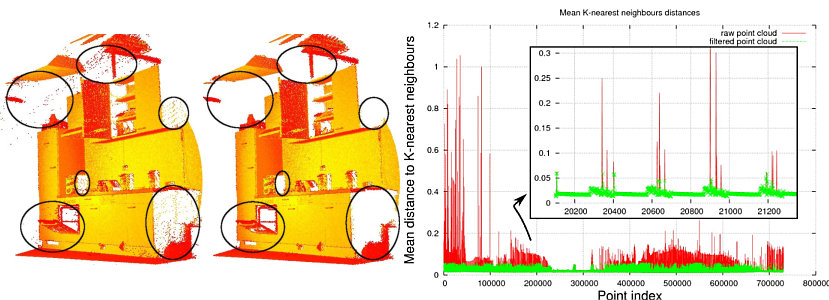

下图显示了一个噪声消除的示例。 由于测量误差,某些数据集会出现大量阴影点。 这使局部点云3D特征的估算变得复杂。==通过对每个点的邻域进行统计分析,并修剪掉不符合特定条件的那些异常值,进而可以过滤掉某些异常值==。

PCL中的实现这些稀疏离群值的消除,需要计算数据集中的点与邻居距离的分布。 即对于每个点,都会计算从它到所有相邻点的平均距离。 通过假设结果分布是具有均值和标准差的高斯分布,可以将那些平均距离在【==由全局距离均值和标准差定义的区间==】之外的所有点视为离群值,并将之从数据集中进行修剪。

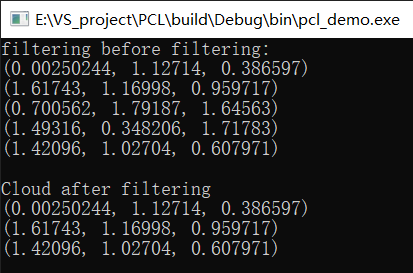

3.1.1 PassThrough-直通滤波

PassThrough:简单来说就是,剔除范围外的点,下面的代码就是把z的值不在0~1的就剔除掉。那么通过重复使用,就可以进行三维空间的滤波

#include <iostream>

#include <pcl/point_types.h>

#include <pcl/filters/passthrough.h> // 这个头文件

#include <pcl/visualization/cloud_viewer.h>

#define PRINT_POINT( point ) \

std::cout << "(" << point.x << ", "<< point.y << ", " << point.z << ")" << std::endl

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud_filtered(new pcl::PointCloud<pcl::PointXYZ>());

cloud->width = 5;

cloud->height = 1;

cloud->points.resize(cloud->width * cloud->height);

for (auto &point : cloud->points) {

point.x = 2 * rand() / (RAND_MAX + 1.0f);

point.y = 2 * rand() / (RAND_MAX + 1.0f);

point.z = 2 * rand() / (RAND_MAX + 1.0f);

}

std::cout << "filtering before filtering: " << std::endl;

for (auto &point : cloud->points) {

PRINT_POINT(point);

}

// 创建一个过滤的对象(一次只能一个轴,多个轴可以考虑多用几次)

pcl::PassThrough<pcl::PointXYZ> passThrough;

passThrough.setInputCloud(cloud); // 1.设置输入源

passThrough.setFilterFieldName("z"); // 2.设置过滤时所需要点云类型的Z字段

passThrough.setFilterLimits(0.0, 1.0); // 3.设置过滤范围(在这个范围内的保留)

passThrough.filter(*cloud_filtered); // 4.执行过滤,结果输出到cloud_filtered

std::cout << "\nCloud after filtering" << std::endl;

for (size_t i = 0; i < cloud_filtered->points.size(); ++i) {

PRINT_POINT(cloud_filtered->points.at(i)); // 宏:打印

}

pcl::visualization::CloudViewer viewer("Cloud Viewer");

// 这里会一直阻塞直到点云被渲染

viewer.showCloud(cloud);

while (!viewer.wasStopped()) {}

return 0;

}

一次输出结果:

从上面代码中的“z”来看,不在0~1之间的点就被剔除掉了。

注:老版本可以passThrough.setFilterLimitsNegative (true);,则以上结果取反。新版本没有这个API了,或许是改变了。

3.1.2 下采样(VoxelGrid&&UniformSampling)

这里写两个下采样的引用实例:

- ==VoxelGrid==:通过体素网格实现降采样,可以在减少点数量的同时,保证点云的形状特征,可以提高配准、曲面重建、形状识别等算法的速度,并保证准确性。

- ==UniformSampling==。

下面这是VoxelGrid的代码:

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/point_types.h>

#include <pcl/filters/voxel_grid.h> // pcl::VoxelGrid类需要

int main(int argc, char* argv[]) {

// 这里用pcl::PointCloud<pcl::PointXYZ>::Ptr 这个类型应该也是可以的

pcl::PCLPointCloud2::Ptr cloud(new pcl::PCLPointCloud2());

pcl::PCLPointCloud2::Ptr cloud_filtered(new pcl::PCLPointCloud2());

// 从文件读取点云图

pcl::PCDReader reader;

reader.read("./table_scene_lms400.pcd", *cloud);

std::cout << "PointCloud before filtering: " << cloud->width * cloud->height

<< " data points (" << pcl::getFieldsList(*cloud) << ")." << std::endl;

// 创建一个长宽高分别是1cm的体素过滤器,cloud作为输入数据,cloud_filtered作为输出数据

float leftSize = 0.01f; // 代表1cm

pcl::VoxelGrid<pcl::PCLPointCloud2> grid;

grid.setInputCloud(cloud);

grid.setLeafSize(leftSize, leftSize, leftSize);

grid.filter(*cloud_filtered);

std::cout << "PointCloud after filtering: " << cloud_filtered->width * cloud_filtered->height

<< " data points (" << pcl::getFieldsList(*cloud_filtered) << ")." << std::endl;;

pcl::PCDWriter writer;

writer.write("./table_scene_lms400_downsampled.pcd", *cloud_filtered);

system("pause");

return 0;

}

可以从输出结果来看,点的数量从原来的460400个减到了41049个,大小也从16M变成了2M(这是看的VoxelGrid的结果)。

双屏对比:pcl_viewer -multiview 1 table_scene_lms400.pcd table_scene_lms400_downsampled.pcd

注意:上面代码的数据格式用的是pcl::PCLPointCloud2,而很多时候其它地方的数据格式用的是pcl::PointCloud<pcl::PointXYZ>,把这这方法结合起来用就少不了这俩格式之间的转换。(3.5 点云表面法线估算中的func3就用到这类型转换)

-

pcl::PointCloud<pcl::PointXYZ> 转换成 pcl::PCLPointCloud2,这是将一个特化的点云转成一个更通用的对象。 请注意,在转换过程中,如果原始点云包含除 pcl::PointXYZ 之外的其他字段(如颜色、法线等),这些字段将不会出现在转换后的 pcl::PCLPointCloud2 对象中,因为 pcl::PCLPointCloud2 是一个动态数据结构,它可以包含任意数量和类型的字段。如果需要保留这些额外的字段,需要在转换之前确保 pcl::PCLPointCloud2 对象已经被正确地设置了这些字段。

#include <pcl/point_types.h> #include <pcl/conversions.h> // 假设 cloud_xyz 是一个已经填充了数据的 pcl::PointCloud<pcl::PointXYZ> 对象 pcl::PointCloud<pcl::PointXYZ>::Ptr cloud_xyz(new pcl::PointCloud<pcl::PointXYZ>); // ... 在这里填充 cloud_xyz 的数据 ... // 创建一个 pcl::PCLPointCloud2 对象来存储转换后的数据 pcl::PCLPointCloud2::Ptr cloud_pcl2(new pcl::PCLPointCloud2); // 将 pcl::PointCloud<pcl::PointXYZ> 转换为 pcl::PCLPointCloud2 pcl::toPCLPointCloud2(*cloud_xyz, *cloud_pcl2); // 主要是这个函数 -

pcl::PCLPointCloud2 是一个通用的点云数据结构,它可以包含各种类型的点(例如 pcl::PointXYZ, pcl::PointXYZRGB, pcl::PointNormal 等)。而 pcl::PointCloud<pcl::PointXYZ> 是一个特化的点云数据结构,只包含 pcl::PointXYZ 类型的点

#include <pcl/point_types.h> #include <pcl/conversions.h> pcl::PCLPointCloud2::Ptr cloud_filtered(new pcl::PCLPointCloud2()); // 假设 cloud_filtered 已经被填充了数据 // 创建一个 pcl::PointCloud<pcl::PointXYZ> 对象 pcl::PointCloud<pcl::PointXYZ>::Ptr cloud_xyz(new pcl::PointCloud<pcl::PointXYZ>()); // 从 pcl::PCLPointCloud2 转换为 pcl::PointCloud<pcl::PointXYZ> pcl::fromPCLPointCloud2(*cloud_filtered, *cloud_xyz); // 主要是这个函数

下面是unifrom_sampling的代码:原来点的数量460400,减到了141525。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/point_types.h>

#include <pcl/filters/uniform_sampling.h> // pcl::UniformSampling 类需要

int main(int argc, char* argv[]) {

// 读取点云

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::io::loadPCDFile("./table_scene_lms400.pcd", *cloud);

std::cout << "original cloud size: " << cloud->size() << std::endl;

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud_uniform(new pcl::PointCloud<pcl::PointXYZ>());

// 使用unifromSampling下采样

pcl::UniformSampling<pcl::PointXYZ> uniform_sampling;

uniform_sampling.setInputCloud(cloud);

double radius = 0.005f;

uniform_sampling.setRadiusSearch(radius);

uniform_sampling.filter(*cloud_uniform);

std::cout << "UniformSampling size: " << cloud_uniform->size() << std::endl;

system("pause");

return 0;

}

总结:

- 注意这种方式里读取点云的方式,两种都是ok的,要都会。

- 从这次结果来看,VoxelGrid似乎可以减小得更多,但可能是参数的设置,没在一个维度。

3.1.3 离群点移除

离群点的去除有多种方式。

(1)StatisticalOutlierRemoval

中文名:(统计学离群点移除过滤器)

实现步骤:

-

查找每一个点的所有领域点;

-

计算每个点到其邻居的距离d~ij~,其中i=[1,…,m]表示共m个点,j=[1,…,k]每个点有k个邻居;

-

根据高斯分布d∼N(μ,σ)模型化距离参数,计算所有点与邻居的μ(距离的均值),σ(距离的标准差),如下: \(\mu=\frac{1}{n k} \sum_{i=1}^{m} \sum_{j=1}^{k} d_{i j}, \\ \sigma=\sqrt{\frac{1}{n k} \sum_{i=1}^{m} \sum_{j=1}^{k}\left(d_{i j}-\mu\right)^{2}}\)

-

为每一个点,计算其与邻居的距离均值 \(\sum_{j=1}^{k} d_{i j}\)

-

遍历所有点,如果其距离的均值大于高斯分布的指定置信度,则移除,比如: \(\sum_{j=1}^{k} d_{i j}>\mu+3 \sigma\)

-

代码实现:

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/point_types.h>

#include <pcl/filters/statistical_outlier_removal.h> // pcl::StatisticalOutlierRemoval 类需要

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud_filtered(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PCDReader reader;

reader.read<pcl::PointXYZ>("./table_scene_lms400.pcd", *cloud);

std::cout << "Cloud before filtering: " << std::endl;

std::cout << *cloud << std::endl;

/*

创建过滤器,每个点分析计算时考虑最近邻居个数为50个;

设置标准差阈值为1,这意味着所有距离查询点的平均距离的标准偏差均大于1个标准偏差的所有点都将被标记为离群值并删除

*/

pcl::StatisticalOutlierRemoval<pcl::PointXYZ> sor;

sor.setInputCloud(cloud);

sor.setMeanK(50); // 设置平均距离估计的最近邻居的数量k

sor.setStddevMulThresh(1.0); // 设置标准差阈值系数

sor.filter(*cloud_filtered); // 过滤并进结果进行保存

std::cout << "Cloud after filtering: " << std::endl;

std::cout << *cloud_filtered << std::endl;

pcl::PCDWriter writer;

// 这是将保留下来的点存为 _inliers.pcd

writer.write<pcl::PointXYZ>("./table_scene_lms400_inliers.pcd", *cloud_filtered);

// 使用的是相通的过滤器,但是对输出结果取反,得到滤去的那些点,存为 _outliers.pcd

sor.setNegative(true);

sor.filter(*cloud_filtered);

writer.write<pcl::PointXYZ>("./table_scene_lms400_outliers.pcd", *cloud_filtered);

system("pause");

return 0;

}

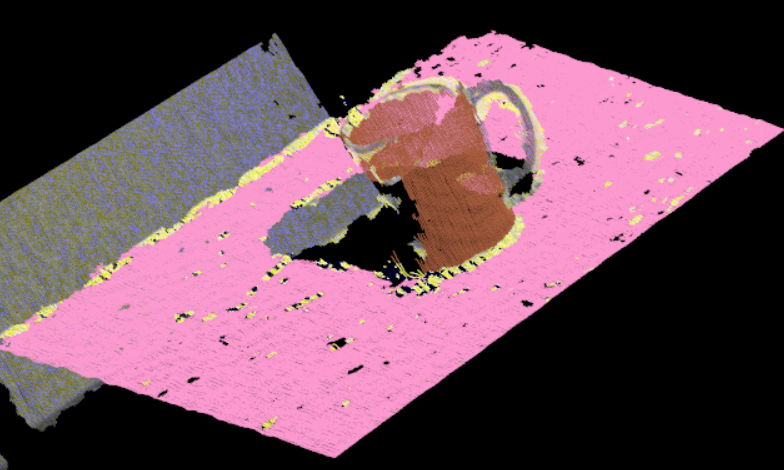

效果:pcl_viewer.exe是PCL安装后,bin中编译好了的。

-

单图对比:

pcl_viewer table_scene_lms400_inliers.pcd table_scene_lms400_outliers.pcd蓝色是前面留下来的点,红色的是剔除的点(上面命令在一个坐标世界同时展示了两个PCD)

-

双图对比:

pcl_viewer -multiview 1 table_scene_lms400_inliers.pcd table_scene_lms400_outliers.pcd

注:如果这个命令参数没给对,就相当于是单图对比的命令,也是单图对比的结果。

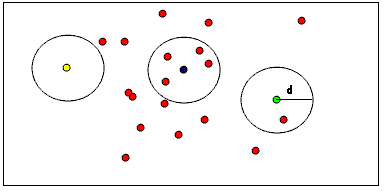

(2)ConditionalRemoval&&RadiusOutlierRemoval

下面是把这两种方式写到了一起

- ==ConditionalRemoval(条件滤波)==:设置不同维度滤波规则进行滤波。 比如保留z在0.25~0.75之间的点。

- ==RadiusOutlierRemoval(半径离群值滤波)==:

如下图,指定邻居的个数,要每个点必须在指定半径内具有指定个邻居才能保留在PointCloud中。下图中,如果指定了1个邻居,则只会从PointCloud中删除黄点;如果指定了2个邻居,则黄色和绿色的点都将从PointCLoud中删除。

代码如下:(两种方式是在一起,去改22行“IF_CONDITION”的值来改变不同的滤波方法)

#include <iostream>

#include <pcl/point_types.h>

#include <pcl/filters/radius_outlier_removal.h>

#include <pcl/filters/conditional_removal.h>

#include <pcl/visualization/pcl_visualizer.h>

#define PRINT_POINT( point ) \

std::cout << "(" << point.x << ", "<< point.y << ", " << point.z << ")" << std::endl

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud_filtered(new pcl::PointCloud<pcl::PointXYZ>());

cloud->width = 100; cloud->height = 1;

cloud->points.resize(cloud->width * cloud->height);

for (auto &point : cloud->points) {

point.x = 1 * rand() / (RAND_MAX + 1.0f);

point.y = 1 * rand() / (RAND_MAX + 1.0f);

point.z = 1 * rand() / (RAND_MAX + 1.0f);

}

bool IF_CONDITION = false; // true:条件滤波;false:半径离群值滤波

if (IF_CONDITION) { // 条件滤波

// 创建过滤条件 (z的值大于0.25,小于0.75)

pcl::ConditionAnd<pcl::PointXYZ>::Ptr range_cond(new pcl::ConditionAnd<pcl::PointXYZ>());

range_cond->addComparison(pcl::FieldComparison<pcl::PointXYZ>::ConstPtr(

new pcl::FieldComparison<pcl::PointXYZ>("z", pcl::ComparisonOps::GT, 0.25)));

range_cond->addComparison(pcl::FieldComparison<pcl::PointXYZ>::ConstPtr(

new pcl::FieldComparison<pcl::PointXYZ>("z", pcl::ComparisonOps::LT, 0.75)));

// 创建条件过滤器

pcl::ConditionalRemoval<pcl::PointXYZ> condrem;

condrem.setInputCloud(cloud);

condrem.setCondition(range_cond);

condrem.setKeepOrganized(true);

// 应用过滤,结果保存到cloud_filtered

condrem.filter(*cloud_filtered);

}

else { // 半径离群值滤波

pcl::RadiusOutlierRemoval<pcl::PointXYZ> ror;

// 创建过滤器

ror.setInputCloud(cloud);

ror.setRadiusSearch(0.15); // 0.15算是超参,越大,搜索半径会大,保留下的点就会更多

ror.setMinNeighborsInRadius(2); // 这就是最小邻居个数,越大满足条件的就少,留下的点就会少

ror.filter(*cloud_filtered);

}

std::cout << "Cloud before filtering: " << std::endl;

for (auto iter = cloud->points.cbegin(); iter != cloud->points.cend(); ++iter) {

PRINT_POINT((*iter));

}

std::cout << "\n\nCloud after filtering: " << std::endl;

for (auto &point : cloud_filtered->points) {

PRINT_POINT(point);

}

// 展示:(先展示原来的点云(绿色),再把过滤后的点云(红色)添加进去,红色的本就是绿色的一部分,位置是一样的,红色的就会把绿色的覆盖,所以看起来就是红的、绿的都有)

pcl::visualization::PCLVisualizer::Ptr viewer(new pcl::visualization::PCLVisualizer("3D viewer"));

viewer->setBackgroundColor(0.05, 0.05, 0.05, 0); // 背景灰色

// 过滤前的点云,(可以指定颜色,也可以去掉single_color参数不设置)(rgb,绿色)

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> single_color(cloud, 0, 255, 0);

viewer->addPointCloud<pcl::PointXYZ>(cloud, single_color, "cloud");

viewer->setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 2, "cloud");

// 过滤后的点云,(红色)

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> single_color2(cloud_filtered, 255, 0, 0);

viewer->addPointCloud<pcl::PointXYZ>(cloud_filtered, single_color2, "cloud_filtered");

viewer->setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 4, "cloud_filtered");

viewer->addCoordinateSystem(1.0);

while (!viewer->wasStopped()) {

viewer->spinOnce();

}

return 0;

}

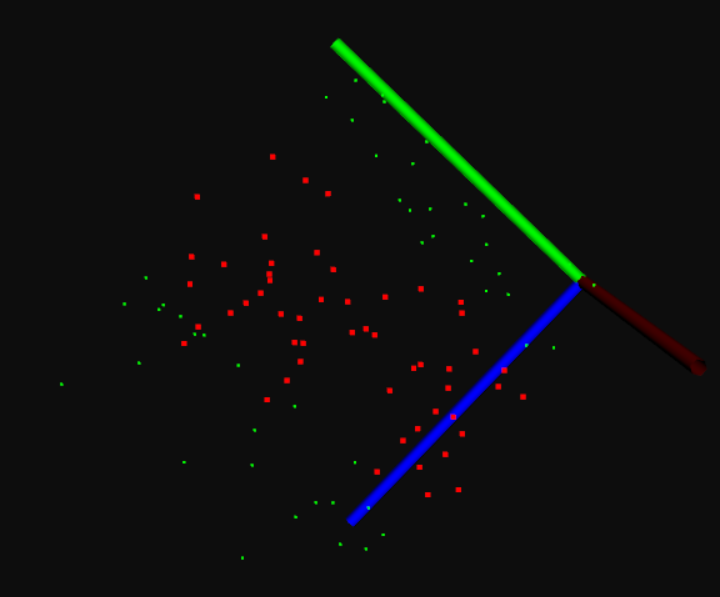

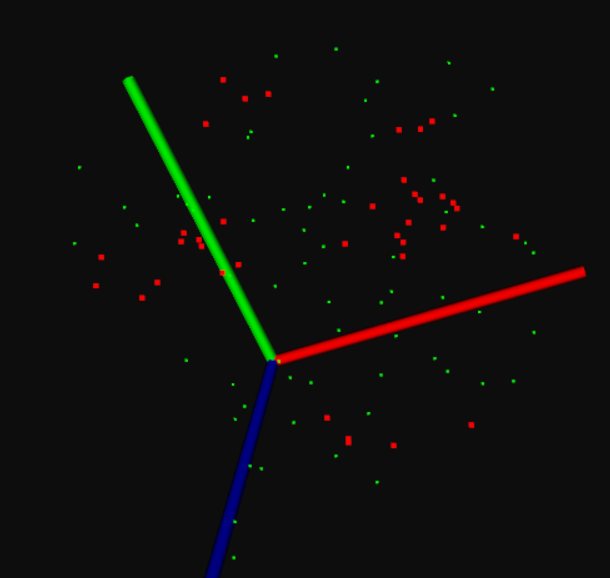

效果展示:(红色为过滤后被保留下的点云,绿色为被过滤掉的点云)

- ConditionalRemoval:(保留的0.25-0.75,所以中间是红色的(过滤后留下的点),两边是绿色的(原来的点))

- RadiusOutlierRemoval:(看代码中设置的条件)

3.1.4 双边滤波

==双边滤波 bilateral filter(BF)==

双边滤波可以帮我们保留边缘信息,其实质也是计算邻居像素的加权平均和,非常类似于高斯卷积。不同之处在于双边滤波器在平滑的同时考虑到与邻边像素颜色值的差异,进而保留边缘信息。双边滤波器的关键思想是一个像素对另一个像素影响程度,不应该只和位置距离有关,还应该具有相似的像素颜色值。因此,双边滤波器是一种非线性滤波器。

即相等距离情况下,颜色值接近的像素点权重应当高一些,颜色值差异大的像素点权重应当小一些。

双边滤波的核函数是空间域核与像素范围域核的综合结果:在图像的平坦区域,像素值变化很小,对应的像素范围域权重接近于1,此时空间域权重起主要作用,相当于进行高斯模糊;在图像的边缘区域,像素值变化很大,像素范围域权重变大,从而保持了边缘的信息。

代码我就放这里了,没去跑过。但问题应该不大。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/point_types.h>

#include <pcl/filters/impl/bilateral.hpp> // 这个跟其它滤波头文件还不大一样,多了一个impl层级

#include <pcl/visualization/pcl_visualizer.h>

void bilateralFilter(pcl::PointCloud<pcl::PointXYZI>::Ptr &input, pcl::PointCloud<pcl::PointXYZI>::Ptr& output) {

pcl::search::KdTree<pcl::PointXYZI>::Ptr tree1(new pcl::search::KdTree<pcl::PointXYZI>);

// Apply the filter

pcl::BilateralFilter<pcl::PointXYZI> fbf;

fbf.setInputCloud(input);

fbf.setSearchMethod(tree1);

fbf.setStdDev(0.1);

fbf.setHalfSize(0.1);

fbf.filter(*output);

}

int main(int argc, char** argv) {

pcl::PointCloud<pcl::PointXYZI>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZI>); // 需要PointXYZI

pcl::PointCloud<pcl::PointXYZI>::Ptr cloud_filtered(new pcl::PointCloud<pcl::PointXYZI>);

pcl::PCDReader reader;

reader.read<pcl::PointXYZI>(argv[1], *cloud);

bilateralFilter(cloud, cloud_filtered);

return (0);

}

3.1.5 工具使用及小结

在pcl的安装目录的bin路径里,是有一些已经编译好的exe可直接使用,如:

-

对一个点云进行降采样:(输入input.pcd,输出output.pcd,使用VoxelGrid)

pcl_voxel_grid input.pcd output.pcd -leaf 0.03,0.03,0.03 # -leaf的含义可以去上面代码中看

然后里面还有其它的已经封好的,以后可以考虑直接调用命令行来实现自己想要的效果。

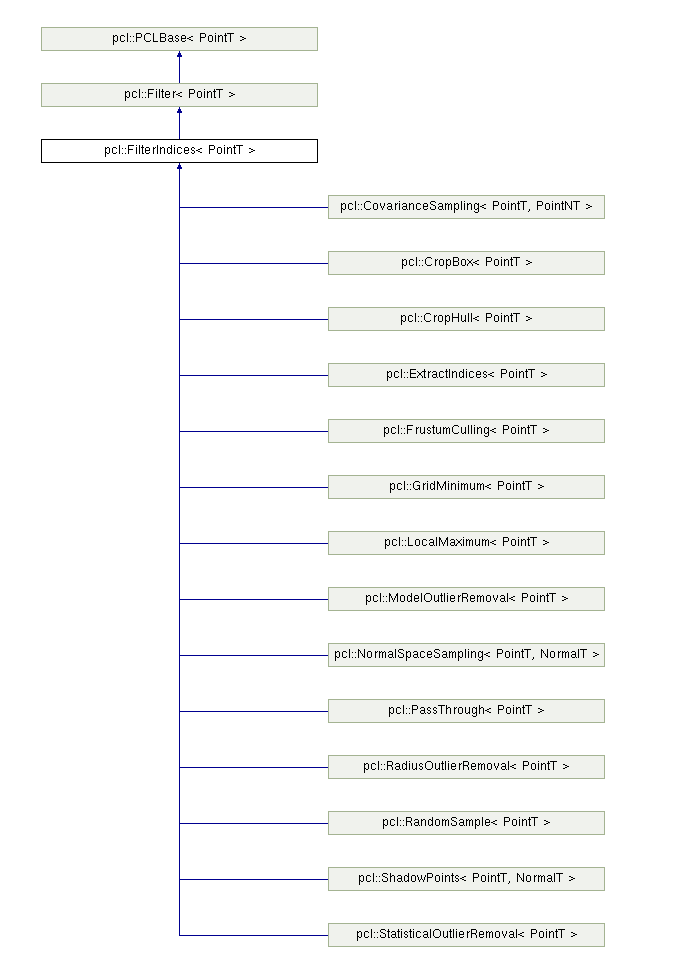

真的用到时,也去看看下面的图,特别是pcl::CropBox,可能会用到,代码实现方式跟上面都差不多,添加对应头文件和类实现就好了。

==点云滤波器的继承关系==:

3.2 深度图RangeImage

3.2.1 从点云创建深度图

目前深度图像的获取方法有==激光雷达深度成像法==,==计算机立体视觉成像==,==坐标测量机法==,==莫尔条纹法==,==结构光法==等等,针对深度图像的研究重点主要集中在以下几个方面:

- 深度图像的分割技术;

- 深度图像的边缘检测技术;

- 基于不同视点的多幅深度图像的配准技术;

- 基于深度数据的三维重建技术;

- 基于三维深度图像的三维目标识别技术;

- 深度图像的多分辨率建模和几何压缩技术等等。

在PCL中深度图像与点云最主要的区别在于其近邻的检索方式的不同,并且可以互相转换。

深度图像(Depth Images)也被称为距离影像(Range Image),是指将从图像采集器到场景中各点的距离值作为像素值的图像,它直接反应了景物可见表面的几何形状,利用它可以很方便的解决3D目标描述中的许多问题,深度图像经过点云变换可以计算为点云数据,有规则及有必要信息的点云数据可以反算为深度图像数据。

==从点云创建深度图==:

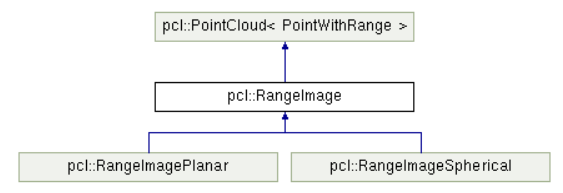

- 主要类是:“pcl::RangeImage”,此类继承于pcl::PointCloud,主要功能是实现一个特定视点得到一个三维场景的深度图像,其继承关系如图:(该类的成员函数及其参数说明教程)

==核心函数及其参数说明==:

-

函数:通过pointCloud点云创建深度图,“createFromPointCloud”

createFromPointCloud(pointCloud, angularResolution, maxAngleWidth, maxAngleHeight, sensorPose, coordinate_frame, noiseLevel, minRange, borderSize)

-

参数解释:

- pointCloud:被检测的点云;

- angularResolution=1:临近的像素点所对应的每个光束之间相差1°。

- maxAngleWidth=360:进行模拟的距离传感器对周围的环境拥有一个完成的360°视角,无论任何数据集都推荐使用此设置,因为最终获取的深度图像将被裁剪到有空间物体存在的区域范围。

- maxAngleHeight=180:当传感器后面没有可以观测的点时,设置一个水平视角为180°的激光扫描仪即可,因为需要观察距离传感器前面就可以了。

- sensorPose:定义了模拟深度图像获取传感器的6DOF(6自由度)位置,其原始值为滚转角roll、俯仰角pitch、偏航角yaw都为0。

- coordinate_frame:(一个枚举值)设置为“CAMERA_FRAME”说明系统的X轴是向右的、Y轴是向下的、Z轴是向前的;设置为“LASER_FRAME”则是X轴向前、Y轴向左、Z轴向上。

- noiseLevel=0:是指使用一个归一化的Z缓存区来创建深度图像,如果相让临近点集都落在同一个像素单元,可以设置一个较高的的值,例如“noiseLevel=0.05”可以理解为深度距离值是通过查询点半径为5cm的圆内包含的点用来平均计算而得到的。

- minRange=0:如果设置>0则所有模拟器所在位置半径minRange内的临近点都将被忽略,即为盲区。

- borderSize=1:如果设置>0,在裁剪图像时,将在图像周围留下当前视点不可见点的边界。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/visualization/pcl_visualizer.h>

#include <pcl/range_image/range_image.h> // 注意别忘了这俩头文件

#include <pcl/visualization/range_image_visualizer.h>

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

// 创建一个矩形形状的点云

for (float y = -0.5f; y <= 0.5f; y += 0.01f) {

for (float z = -0.5f; z <= 0.5f; z += 0.01f) {

cloud->points.push_back(pcl::PointXYZ(2.0f - y, y, z));

}

}

cloud->width = static_cast<uint32_t>(cloud->points.size());

cloud->height = 1;

// 或者直接加载一个已有的点云

//pcl::io::loadPCDFile("C:\\Users\\Administrator\\Downloads\\rabbit.pcd", *cloud); //

// 根据前面得到的点云图(核心是下面这些参数),通过1deg的分辨率生成深度图

float angularResolution = static_cast<float>(1.0f * (M_PI / 180.0f)); // 1°

float maxAngleWidth = static_cast<float>(360.0f * (M_PI / 180.0f)); // 360°

float maxAngleHeight = (float)(180.0f * (M_PI / 180.0f)); // 180°

Eigen::Affine3f sensorPose = static_cast<Eigen::Affine3f>(Eigen::Translation3f(0.0f, 0.0f, 0.0f)); // 采集位置

pcl::RangeImage::CoordinateFrame coordinate_frame = pcl::RangeImage::CAMERA_FRAME; // 相机坐标系

float noiseLevel = 0.0f;

float minRange = 0.0f;

int borderSize = 1;

//boost::shared_ptr<pcl::RangeImage> rangeImage(new pcl::RangeImage());

std::shared_ptr<pcl::RangeImage> rangeImage(new pcl::RangeImage());

rangeImage->createFromPointCloud(*cloud, angularResolution, maxAngleWidth, maxAngleHeight, sensorPose, coordinate_frame, noiseLevel, minRange, borderSize);

std::cout << *rangeImage << std::endl;

pcl::visualization::PCLVisualizer viewer("3D Viewer");

viewer.setBackgroundColor(1, 1, 1);

// 添加原始点云图 (橘红色)

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> cloud_color(cloud, 255, 100, 0);

viewer.addPointCloud(cloud, cloud_color, "original image");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 2, "original image");

// 添加深度图点云(黑色的点)

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> range_img_color_handler(rangeImage, 0, 0, 0);

viewer.addPointCloud(rangeImage, range_img_color_handler, "range image");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 4, "range image"); // 这里名字要跟上一行中的名字保持一致

viewer.initCameraParameters();

viewer.addCoordinateSystem(1.0);

while (!viewer.wasStopped()) {

viewer.spinOnce();

pcl_sleep(0.01);

}

return 0;

}

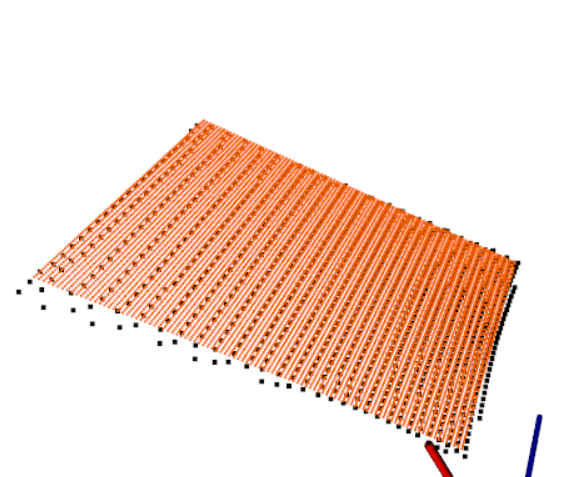

效果:(橘红色为原始点云,黑色的是深度图)

- 这是生成的矩形形状的点云:

- 这是兔子的深度图(把它原始点云没再展示):

3.2.2 从深度图提取边界

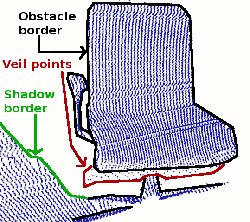

通常对三种不同类型的点感兴趣:

- obstacle border:对象边界(属于对象的最外面的可见点)

- veil points:面纱点集(对象边界与阴影边界之间的内插点)

- shadow boeder:阴影边界(在背景中与遮挡物相邻的点)

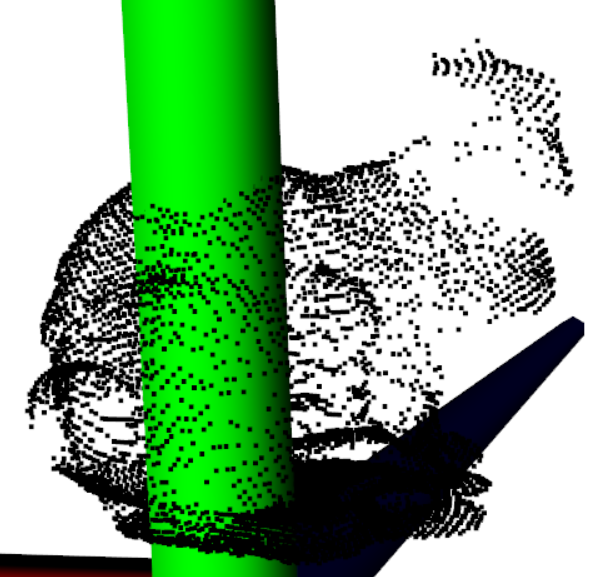

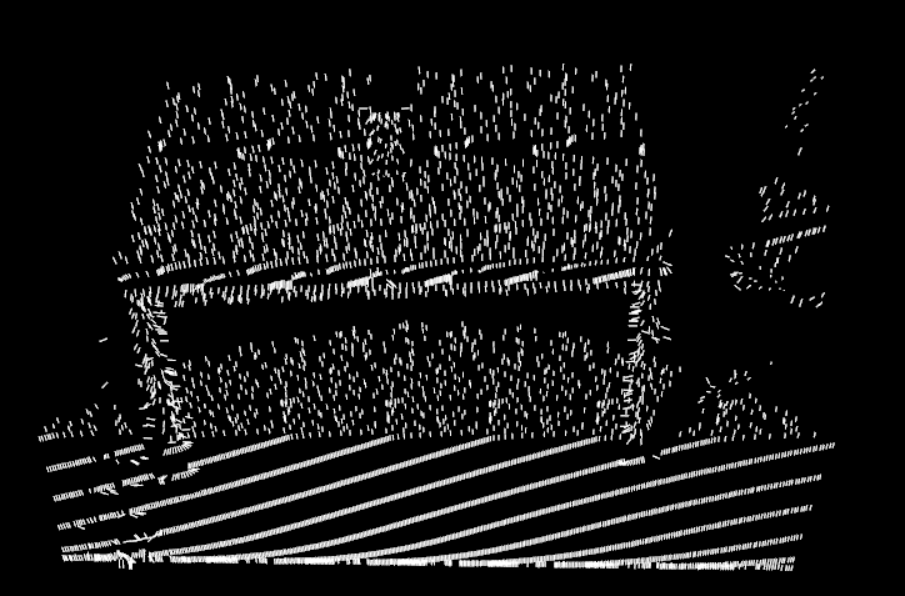

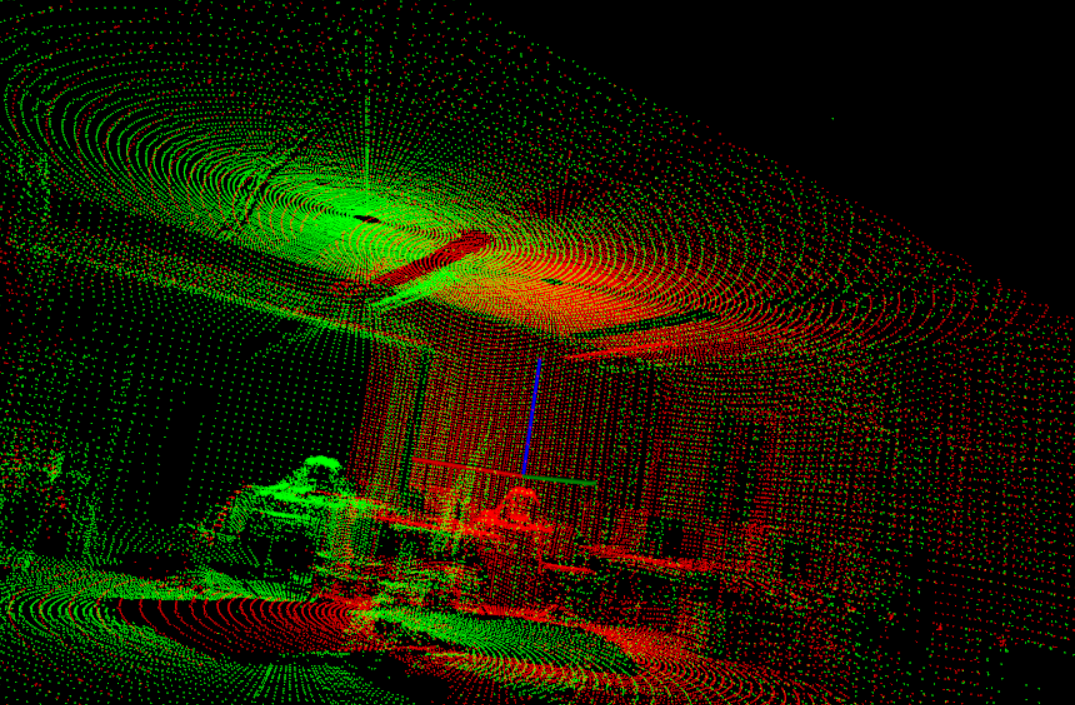

下图是一个典型的激光雷达获得的3D数据对应的点云图:

代码实现中有个注意事项: 要提取边界信息,重要的是区分==未观察到的图像点==和==应该观察到但超出传感器范围的点==。后者通常用来标记边界,而未观察到的点通常不标记边界,因此最好可以提供这些测量信息,如果无法提供超出这些应该观察到的传感器范围的带你,则可以使用==setUnseenToMaxRange函数==,将那些点设置为最大深度(下面代码就添加了-m参数)。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/visualization/pcl_visualizer.h>

#include <pcl/range_image/range_image.h>

#include <pcl/visualization/range_image_visualizer.h>

#include <pcl/features/range_image_border_extractor.h> // 相比上一小节新增的头文件

#include <pcl/console/parse.h> // 这个主要用来分析传入的参数

// 全局参数

float angular_resolution = 0.5f;

pcl::RangeImage::CoordinateFrame coordinate_frame = pcl::RangeImage::LASER_FRAME;

bool setUnseenToMaxRange = false;

void printUsage(const char* progName) {

std::cout << "\n\nUsage: " << progName << " [options] <sample.pcd>\n\n"

<< "Options:\n"

<< "-----------------------------------------\n"

<< "-r <float> angular resolution in degree (default " << angular_resolution << ")\n"

<< "-c <int> coordinate frame (default " << (int)coordinate_frame << ")\n"

<< "-m Treat all unseen points to max range\n"

<< "-h this help\n"

<< "\n\n";

}

int main(int argc, char* argv[]) {

if (pcl::console::find_argument(argc, argv, "-h") >= 0) {

printUsage(argv[0]);

return 0;

}

if (pcl::console::find_argument(argc, argv, "-m") >= 0) {

setUnseenToMaxRange = true;

std::cout << "Setting unseen values in range image to maximum range readings." << std::endl;

}

int tmp_coordinate_frame;

if (pcl::console::parse(argc, argv, "-c", tmp_coordinate_frame) >= 0) {

std::cout << "Using coordinate frame " << tmp_coordinate_frame << std::endl;

coordinate_frame = static_cast<pcl::RangeImage::CoordinateFrame>(tmp_coordinate_frame);

}

if (pcl::console::parse(argc, argv, "-r", angular_resolution) >= 0) {

std::cout << "Setting angular resolution to " << angular_resolution << "deg.\n";

}

angular_resolution = pcl::deg2rad(angular_resolution);

// 第一步:读取PCD文件(没给pcd文件的话就自己创建一个点云)

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointWithViewpoint>::Ptr far_ranges; // 这个信息一般都没有,大抵到后面就是空指针

Eigen::Affine3f scene_sensor_pose(Eigen::Affine3f::Identity()); // 传感器位置

std::vector<int> pcl_filename_indices = pcl::console::parse_file_extension_argument(argc, argv, "pcd");

if (!pcl_filename_indices.empty()) {

std::string filename = argv[pcl_filename_indices.at(0)];

if (pcl::io::loadPCDFile(filename, *cloud) == -1) {

std::cout << "Was not able to opem file \"" << filename << "\".\n";

printUsage(argv[0]);

return 0;

}

auto &sensor_origin = cloud->sensor_origin_;

scene_sensor_pose = Eigen::Affine3f(Eigen::Translation3f(sensor_origin[0], sensor_origin[1], sensor_origin[2])) * Eigen::Affine3f(cloud->sensor_orientation_);

// 好像本来也没有这个文件,命令行也没传进来这个文件

std::string far_ranges_filename = filename.replace(filename.find(".pcd"), 4, "_far_ranges.pcd");

if (pcl::io::loadPCDFile(far_ranges_filename, *far_ranges) == -1) {

std::cout << "Far ranges file \"" << far_ranges_filename << "\" does not exists.\n";

}

}

else { // 文件加载失败就自己创建一个点云

std:cout << "\nNo *.pcd file given => Generating example point cloud.\n\n";

for (float x = -0.5f; x <= 0.5f; x += 0.01f) {

for (float y = -0.5f; y <= 0.5f; y+= 0.01f) {

cloud->points.push_back(pcl::PointXYZ(x, y, 2.0f - y));

}

}

cloud->width = (int)cloud->points.size();

cloud->height = 1;

}

// 第二步:从点云创建深度图RangeImage

float noise_level = 0.0f;

float min_range = 0.0f;

int border_size = 1;

std::shared_ptr<pcl::RangeImage> rangeImage(new pcl::RangeImage());

// 下一行函数中的参数含义去看上一小节

rangeImage->createFromPointCloud(*cloud, angular_resolution, pcl::deg2rad(360.0f), pcl::deg2rad(180.0f), scene_sensor_pose, coordinate_frame, noise_level, min_range, border_size);

// 要先判断是不是空指针

if (far_ranges)

rangeImage->integrateFarRanges(*far_ranges);

if (setUnseenToMaxRange) // 上面的全局变量

rangeImage->setUnseenToMaxRange();

// 第三步:提取边界borders

pcl::RangeImageBorderExtractor border_exteator(&(*rangeImage)); // 这里接受指针,但是智能指针放进去由自动转换不了,就先解引用,再取地址。

pcl::PointCloud<pcl::BorderDescription> border_descriptions;

border_exteator.compute(border_descriptions); // 提取边界计算描述子

// 下面这行是定义了3个同一类型的指针变量

pcl::PointCloud<pcl::PointWithRange>::Ptr

border_points(new pcl::PointCloud<pcl::PointWithRange>()), // 物体边界

veil_points(new pcl::PointCloud<pcl::PointWithRange>()), // veil边界

shadow_points(new pcl::PointCloud<pcl::PointWithRange>()); // 阴影边界

for (uint32_t y = 0; y < rangeImage->height; ++y) {

for (uint32_t x = 0; x < rangeImage->width; ++x) {

auto idx = y * rangeImage->width + x;

auto &desc = border_descriptions.points.at(idx);

if (desc.traits[pcl::BORDER_TRAIT__OBSTACLE_BORDER])

border_points->points.push_back(rangeImage->points[idx]);

if (desc.traits[pcl::BORDER_TRAIT__VEIL_POINT])

veil_points->points.push_back(rangeImage->points[idx]);

if (desc.traits[pcl::BORDER_TRAIT__SHADOW_BORDER])

shadow_points->points.push_back(rangeImage->points[idx]);

}

}

// 第四步:3D展示

// 4.1:展示原始点云

pcl::visualization::PCLVisualizer viewer("3D Viewer");

viewer.setBackgroundColor(1, 1, 1);

viewer.addCoordinateSystem(1.0f, "global"); // 设置坐标系

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> cloud_color_handler(cloud, 0, 0, 0);

viewer.addPointCloud(cloud, cloud_color_handler, "original point cloud");

// 4.1:展示深度图(也可以不要)

//pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> range_img_color_handler(rangeImage, 150, 150, 150);

//viewer.addPointCloud(rangeImage, range_img_color_handler, "range image");

//viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 2, "range image");

// 4.2:展示边界点

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> border_points_handler(border_points, 0, 255, 0);

viewer.addPointCloud<pcl::PointWithRange>(border_points, border_points_handler, "border points");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 7, "border points");

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> veil_points_handler(veil_points, 255, 0, 0);

viewer.addPointCloud<pcl::PointWithRange>(veil_points, veil_points_handler, "veil points");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 7, "veil points");

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> shadow_points_handler(shadow_points, 0, 255, 255);

viewer.addPointCloud<pcl::PointWithRange>(shadow_points, shadow_points_handler, "shadow points");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 7, "shadow points");

// show points in range image (深度图展示)

pcl::visualization::RangeImageVisualizer* range_img_border_widget = nullptr;

range_img_border_widget = pcl::visualization::RangeImageVisualizer::getRangeImageBordersWidget(

*rangeImage, -std::numeric_limits<float>::infinity(), std::numeric_limits<float>::infinity(), false, border_descriptions, "Range image with borders");

while (!viewer.wasStopped()) {

range_img_border_widget->spinOnce();

viewer.spinOnce();

pcl_sleep(0.01);

}

return 0;

}

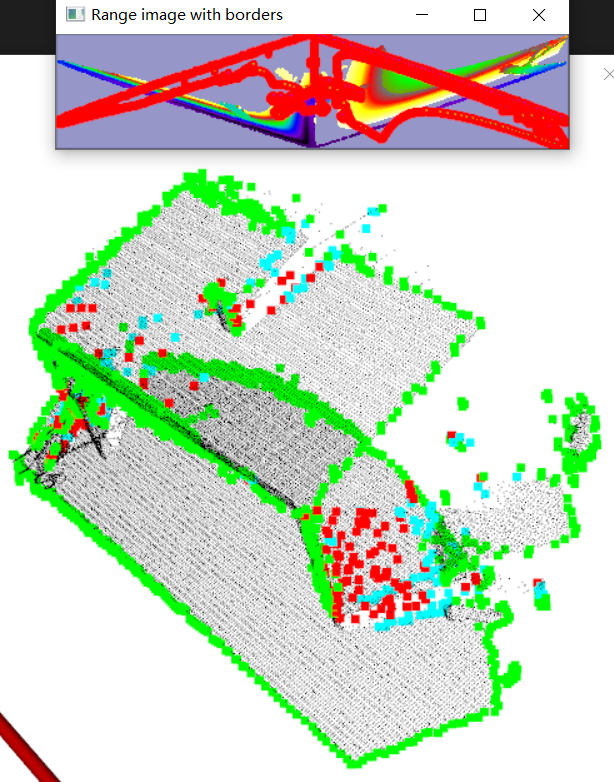

上面代码编译成”pcl_demo.exe”后,执行:pcl_demo.exe -m table_scene_lms400_downsampled.pcd

效果:

根据上面代码指定的颜色:

-

绿色:border_points(边界点)

- 红色:veil_points(面纱点集)

- 青色:shadow_points(阴影边界)

3.3 关键点提取

3.3.1 NARF

从技术上来说,关键点的数量比原始点云或图像的数据量少很多,其与局部特征描述子结合组成关键点描述子。 ==NARF==(Normal Aligned Radial Feature)关键点是为了从深度图像中识别物体而提出的,关键点探测的重要异步是减少特征提取时的搜索空间,把重点放在重要的结构上,对NARF关键点提取过程有以下要求:

- 提取的过程必须考虑边缘以及物体表面变化信息;

- 即使换了不同的视角,关键点的位置必须稳定的可以被重复探测;

- 关键点所在的位置必须有稳定的支持区域,可以计算描述子和估计唯一的法向量。

为了满足上述需求,可以通过一下探测步骤来进行关键点提取:

- 遍历每个==深度图像点==,通过寻找在近邻区域有深度突变的位置进行边缘检测;

- 遍历每个深度图像点,根据近邻区域的表面变化决定来测度表面变化的系数,以及变化的主方向;

- 根据上一步找到的主方向计算兴趣值,表征该方向与其它方向的不同,以及该处表面的变化情况,即改点有多稳定;

- 对兴趣值进行平滑的过滤;

- 进行无最大值压缩找到最终的关键点,即为NARF关键点。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/console/parse.h> // 参数分析

#include <pcl/visualization/pcl_visualizer.h>

#include <pcl/range_image/range_image.h> // 深度图像

#include <pcl/visualization/range_image_visualizer.h>

#include <pcl/features/range_image_border_extractor.h> // 深度图像找边界点

#include <pcl/keypoints/narf_keypoint.h> // 关键点查找的头文件

#include <pcl/features/narf_descriptor.h>

// 全局参数,具体看上一节的使用

float angular_resolution = 0.5f;

float support_size = 0.2f;

pcl::RangeImage::CoordinateFrame coordinate_frame = pcl::RangeImage::CoordinateFrame::CAMERA_FRAME;

bool setUnseenToMaxRange = false;

bool rotation_invariant = true; // 这一节新增的参数(非必须)

void printUsage(const char *progName) {

std::cout << "\n\nUsage: " << progName << " [options] <sample.pcd>\n\n"

<< "Options:\n"

<< "-------------------------------------------\n"

<< "-r <float> angular resolution in degrees (default " << angular_resolution << ")\n"

<< "-c <int> coordinate frame (default " << (int)coordinate_frame << ")\n"

<< "-m Treat all unseen points as maximum range readings\n"

<< "-s <float> support size for the interest points (diameter of the used sphere - "

<< "default " << support_size << ")\n"

<< "-o <0/1> switch rotational invariant version of the feature on/off "

<< " (defaule " << (int)rotation_invariant << ")\n"

<< "-h this help!\n\n\n";

}

// 设置视口的位姿

void setViewerPose(pcl::visualization::PCLVisualizer &viewer, const Eigen::Affine3f &viewer_pose) {

// 视口的原点pos_vector

Eigen::Vector3f pos_vector = viewer_pose * Eigen::Vector3f(0, 0, 0);

// 旋转+平移look_at_vector

Eigen::Vector3f look_at_vector = viewer_pose.rotation() * Eigen::Vector3f(0, 0, 1) + pos_vector;

// up_vector

Eigen::Vector3f up_vector = viewer_pose.rotation() * Eigen::Vector3f(0, -1, 0);

// 设置照相机的位姿

viewer.setCameraPosition(pos_vector[0], pos_vector[1], pos_vector[2], up_vector[0], up_vector[1], up_vector[2]);

}

int main(int argc, char* argv[]) {

if (pcl::console::find_argument(argc, argv, "-h") >= 0) {

printUsage(argv[0]);

return 0;

}

if (pcl::console::find_argument(argc, argv, "-m") >= 0) {

setUnseenToMaxRange = true;

std::cout << "Setting unseen values in range image to maximum range readings.\n";

}

int tmp_coordinate_frame;

if (pcl::console::parse(argc, argv, "-c", tmp_coordinate_frame) >= 0) {

coordinate_frame = (pcl::RangeImage::CoordinateFrame)tmp_coordinate_frame;

std::cout << "Using coordinate frame " << (int)coordinate_frame << ".\n";

}

if (pcl::console::parse(argc, argv, "-s", support_size) >= 0)

std::cout << "Setting support size to " << support_size << ".\n";

if (pcl::console::parse<float>(argc, argv, "-r", angular_resolution) >= 0)

std::cout << "Setting angular resolution to " << angular_resolution << "deg.\n";

angular_resolution = pcl::deg2rad(angular_resolution);

// 第一步:读取PCD文件(没给pcd文件的话就自己创建一个点云)

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointWithViewpoint>::Ptr far_ranges; // 这个信息一般都没有,大抵到后面就是空指针

Eigen::Affine3f scene_sensor_pose(Eigen::Affine3f::Identity()); // 传感器位置

std::vector<int> pcl_filename_indices = pcl::console::parse_file_extension_argument(argc, argv, "pcd");

if (!pcl_filename_indices.empty()) {

std::string filename = argv[pcl_filename_indices.at(0)];

if (pcl::io::loadPCDFile(filename, *cloud) == -1) {

std::cout << "Was not able to opem file \"" << filename << "\".\n";

printUsage(argv[0]);

return 0;

}

auto &sensor_origin = cloud->sensor_origin_;

scene_sensor_pose = Eigen::Affine3f(Eigen::Translation3f(sensor_origin[0], sensor_origin[1], sensor_origin[2])) * Eigen::Affine3f(cloud->sensor_orientation_);

// 好像本来也没有这个文件,命令行也没传进来这个文件

std::string far_ranges_filename = filename.replace(filename.find(".pcd"), 4, "_far_ranges.pcd");

if (pcl::io::loadPCDFile(far_ranges_filename, *far_ranges) == -1) {

std::cout << "Far ranges file \"" << far_ranges_filename << "\" does not exists.\n";

}

}

else { // 文件加载失败就自己创建一个点云

setUnseenToMaxRange = true;

std:cout << "\nNo *.pcd file given => Generating example point cloud.\n\n";

for (float x = -0.5f; x <= 0.5f; x += 0.01f) {

for (float y = -0.5f; y <= 0.5f; y += 0.01f) {

cloud->points.push_back(pcl::PointXYZ(x, y, 2.0f - y));

}

}

cloud->width = (int)cloud->points.size();

cloud->height = 1;

}

// 第二步:从点云创建深度图RangeImage

float noise_level = 0.0f;

float min_range = 0.0f;

int border_size = 1;

std::shared_ptr<pcl::RangeImage> rangeImage(new pcl::RangeImage());

// 此函数中的参数含义去看上一小节

rangeImage->createFromPointCloud(*cloud, angular_resolution, pcl::deg2rad(360.0f), pcl::deg2rad(180.0f), scene_sensor_pose, coordinate_frame, noise_level, min_range, border_size);

// 要先判断是不是空指针

if (far_ranges) rangeImage->integrateFarRanges(*far_ranges);

if (setUnseenToMaxRange) rangeImage->setUnseenToMaxRange();

// 第三步:点云展示,(至此的代码跟从深度图提取边界是一样的)

pcl::visualization::PCLVisualizer viewer("3D Viewer");

viewer.setBackgroundColor(1, 1, 1);

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> rangeImage_handler(rangeImage, 0, 0, 0);

viewer.addPointCloud(rangeImage, rangeImage_handler, "range image"); // 深度图的点云

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 1, "range image");

//viewer.addCoordinateSystem(1.0f, "global"); // 设置坐标系(没这行,就没有那三根坐标系)

// 原始点云,可显示可不显示

//pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> cloud_color_handler(cloud, 0, 0, 0);

//viewer.addPointCloud(cloud, cloud_color_handler, "original point cloud");

viewer.initCameraParameters();

// 有的教程又没有执行这一步,不是很理解

setViewerPose(viewer, rangeImage->getTransformationToWorldSystem());

// 上面是深度图的点云展示,这是深度图展示(就是另外弹出的一个小框)

pcl::visualization::RangeImageVisualizer range_img_widget("Range image");

range_img_widget.showRangeImage(*rangeImage);

// 第四步:提取 NARF 关键点

// 创建RangeImageBorderExtractor对象,它是用来进行边缘提取的,因为NARF的第一步就需要探测出深度图的边缘

pcl::RangeImageBorderExtractor range_image_border_extrator; // 用来提取边缘

pcl::NarfKeypoint narf_keypoint_detector; // 用来检测关键点

narf_keypoint_detector.setRangeImageBorderExtractor(&range_image_border_extrator);

narf_keypoint_detector.setRangeImage(&(*rangeImage));

narf_keypoint_detector.getParameters().support_size = support_size; // 设置NARF的参数

// 下面这两行设置参数的,教程里有但也是注释掉的

//narf_keypoint_detector.getParameters().add_points_on_straight_edges = true;

//narf_keypoint_detector.getParameters().distance_for_additional_points = 0.5;

pcl::PointCloud<int> keypoint_indices;

narf_keypoint_detector.compute(keypoint_indices);

std::cout << "Found " << keypoint_indices.points.size() << " key points." << std::endl;

// 看是否在深度图(非点云的)的单独窗口展示中显示关键点,要得话就把这几行注视掉

//for (size_t i = 0; i < keypoint_indices.points.size(); ++i) {

// range_img_widget.markPoint(keypoint_indices.points[i] % rangeImage->width, keypoint_indices.points[i] / rangeImage->width); // 这行代码有问题

//}

// 第五步:在3D图中展示关键点

pcl::PointCloud<pcl::PointXYZ>::Ptr keypoints(new pcl::PointCloud<pcl::PointXYZ>());

keypoints->points.resize(keypoint_indices.size());

for (size_t i = 0; i < keypoint_indices.size(); ++i) {

keypoints->points[i].getVector3fMap() = rangeImage->points[keypoint_indices.points[i]].getVector3fMap();

}

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> keypoints_color_handler(keypoints, 0, 255, 0);

viewer.addPointCloud<pcl::PointXYZ>(keypoints, keypoints_color_handler, "keypoints");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 7, "keypoints");

// (非必须)提取兴趣点的NARF描述符 (这个不是很明白用处)

std::vector<int> keypoints_indices2;

keypoints_indices2.resize(keypoint_indices.points.size());

for (size_t i = 0; i < keypoints_indices2.size(); ++i)

keypoints_indices2[i] = keypoint_indices.points[i];

pcl::NarfDescriptor narf_descriptor(&(*rangeImage), &keypoints_indices2);

narf_descriptor.getParameters().support_size = support_size;

narf_descriptor.getParameters().rotation_invariant = rotation_invariant;

pcl::PointCloud<pcl::Narf36> narf_descriptors;

narf_descriptor.compute(narf_descriptors);

std::cout << "Extracted " << narf_descriptors.size() << " descriptors for " << keypoint_indices.points.size() << " keypoints." << std::endl;

while (!viewer.wasStopped()) {

range_img_widget.spinOnce();

viewer.spinOnce();

pcl_sleep(0.01);

}

return 0;

}

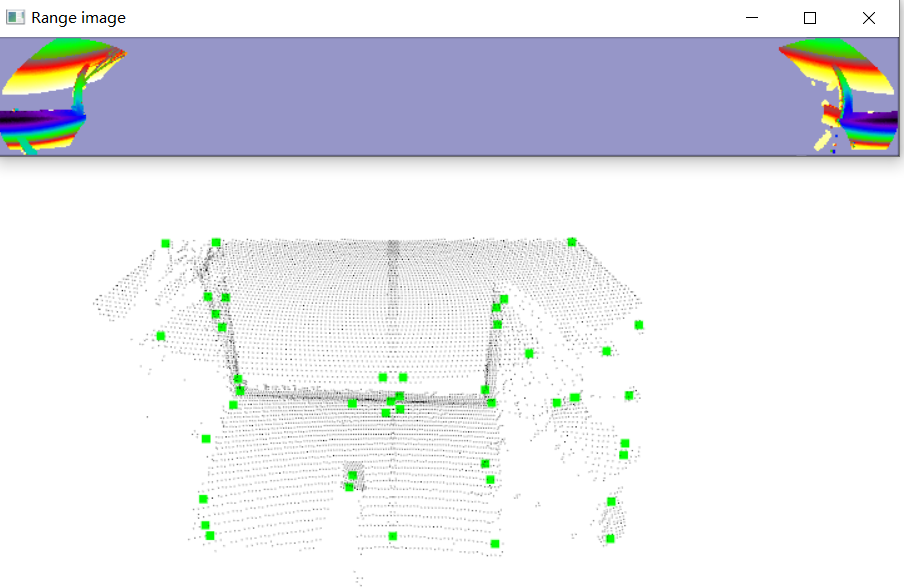

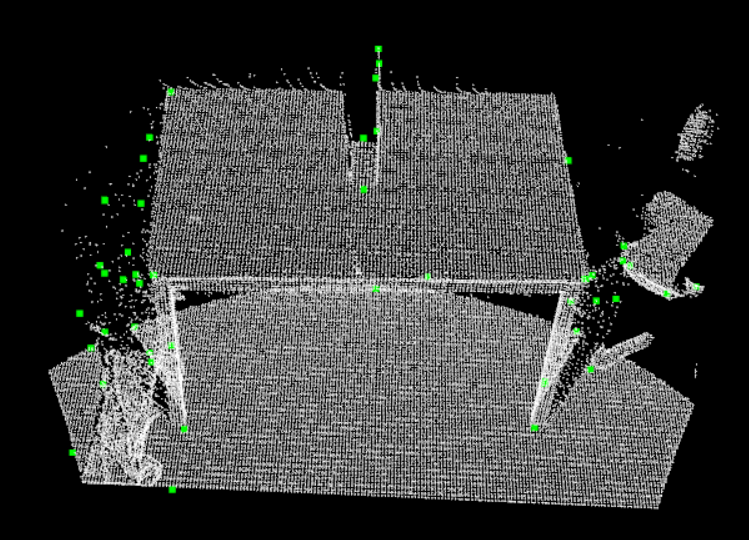

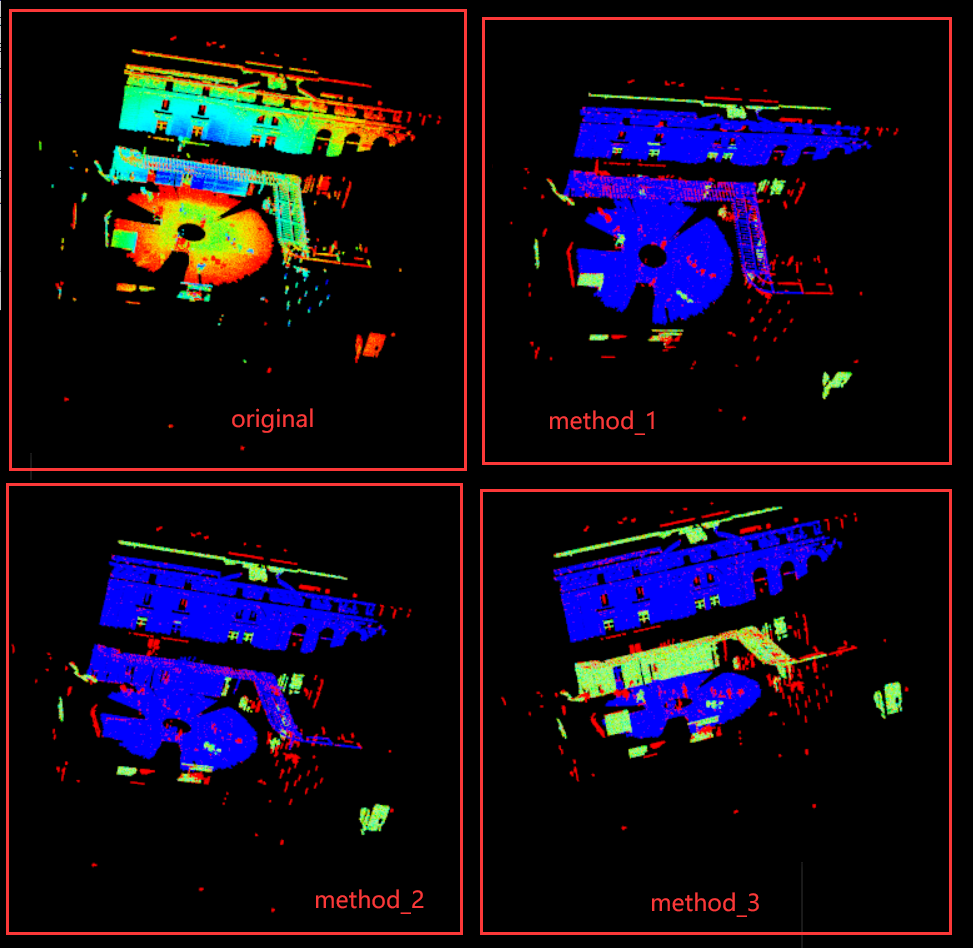

效果:pcl_demo.exe -m table_scene_lms400_downsampled.pcd (绿色的就是关键点)

注意:

- 可能看到的是一片空白,那是坐标的问题,在界面滑动一下鼠标缩放一下就能看到这个界面。

- 上面第123行代码“viewer.addCoordinateSystem(1.0f, “global”);”,加上就是有那三根x、y、z轴的显示,不加就没有。

3.3.2 ISS-Keypoint3D

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/keypoints/iss_3d.h>

#include <pcl/visualization/pcl_visualizer.h>

// 用于计算分辨率

double computeCloudResolution(const pcl::PointCloud<pcl::PointXYZ>::ConstPtr &cloud) {

double resolution = 0.0;

int numberOfPoints = 0;

int nres;

std::vector<int> indices(2);

std::vector<float> squareDistances(2);

pcl::search::KdTree<pcl::PointXYZ> tree;

tree.setInputCloud(cloud);

// 这俩是一模一样的,(因为cloud中重载了[],然后里面函数返回的就是cloud->points[])

//std::cout << cloud->points[0] << std::endl;

//std::cout << "\n\n" << (*cloud)[0] << std::endl;

for (size_t i = 0; i < cloud->size(); ++i) {

// pcl::isFinite是判断一个浮点数是否是有限的(下面两个写法是一个意思)(要pcl/keypoints/iss_3d.h头文件)

//if (!pcl::isFinite((*cloud)[i])) continue;

if (!pcl::isFinite(cloud->points[i])) continue;

// 考虑第二个邻居,因为第一个点是它本身

nres = tree.nearestKSearch(i, 2, indices, squareDistances);

if (nres == 2) {

resolution += std::sqrt(squareDistances[1]);

++numberOfPoints;

}

}

if (numberOfPoints != 0)

resolution /= numberOfPoints;

return resolution;

}

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::io::loadPCDFile("./table_scene_lms400_downsampled.pcd", *cloud);

std::cout << "original cloud size: " << cloud->size() << std::endl;

double resolution = computeCloudResolution(cloud);

pcl::search::KdTree<pcl::PointXYZ>::Ptr tree(new pcl::search::KdTree<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointXYZ>::Ptr keypoints(new pcl::PointCloud<pcl::PointXYZ>());

pcl::ISSKeypoint3D<pcl::PointXYZ, pcl::PointXYZ> iss_detector;

iss_detector.setSearchMethod(tree);

iss_detector.setSalientRadius(6 * resolution);

iss_detector.setNonMaxRadius(4 * resolution);

iss_detector.setThreshold21(0.975);

iss_detector.setThreshold32(0.975);

iss_detector.setMinNeighbors(5);

iss_detector.setNumberOfThreads(4);

iss_detector.setInputCloud(cloud);

iss_detector.compute(*keypoints); // 这里计算得到关键点点云

std::cout << "keypoints cloud size: " << keypoints->size() << std::endl;

pcl::visualization::PCLVisualizer viewer("viewer");

viewer.addPointCloud(cloud); // 原始点云

// 展示关键点点云

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> keypoints_color_handler(keypoints, 0, 255, 0);

viewer.addPointCloud(keypoints, keypoints_color_handler, "keypoints");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 5, "keypoints");

while (!viewer.wasStopped()) {

viewer.spinOnce();

}

return 0;

}

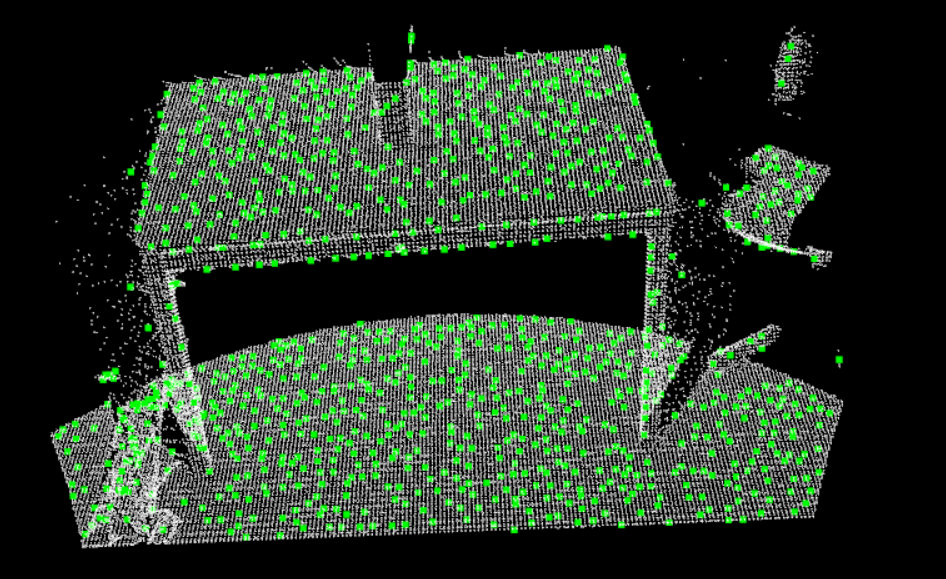

输出:original cloud size: 41049 keypoints cloud size: 1054

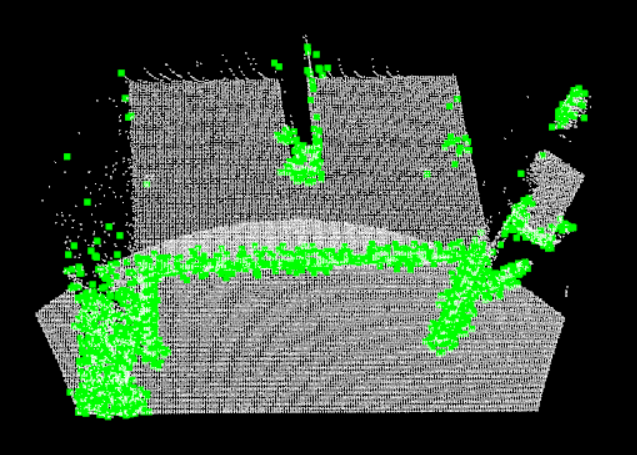

效果:(绿色的就是关键点,为了更明显,关键点展示时还放大了5倍)

3.3.3 Harris-Keypoints3D

HarrisKeypoints3D是对2D的Harris提取关键点算法的一个三维扩展。

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/keypoints/harris_3d.h>

#include <pcl/visualization/pcl_visualizer.h>

// 用于计算分辨率(实现去看3.3.2中的同名函数,一模一样)

double computeCloudResolution(const pcl::PointCloud<pcl::PointXYZ>::ConstPtr &cloud) {}

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::io::loadPCDFile("./table_scene_lms400_downsampled.pcd", *cloud);

std::cout << "original cloud size: " << cloud->size() << std::endl;

double resolution = computeCloudResolution(cloud);

pcl::search::KdTree<pcl::PointXYZ>::Ptr tree(new pcl::search::KdTree<pcl::PointXYZ>());

// 注意keypoints、harris_detector模板里面类型是“PointXYZI”,不是PointXYZ

pcl::PointCloud<pcl::PointXYZI>::Ptr tmp_keypoints(new pcl::PointCloud<pcl::PointXYZI>());

pcl::HarrisKeypoint3D<pcl::PointXYZ, pcl::PointXYZI> harris_detector;

harris_detector.setNonMaxSupression(true);

harris_detector.setRadiusSearch(10 * resolution);

harris_detector.setThreshold(1E-6);

harris_detector.setSearchMethod(tree); // 不写也可以,默认构建kdtree

harris_detector.setInputCloud(cloud);

harris_detector.compute(*tmp_keypoints); // 计算得到关键点的点云

pcl::console::print_highlight("Detected %d points!\n", tmp_keypoints->size());

// 复制弄到最终结果

pcl::PointCloud<pcl::PointXYZ>::Ptr keypoints(new pcl::PointCloud<pcl::PointXYZ>);

pcl::copyPointCloud(*tmp_keypoints, *keypoints);

pcl::visualization::PCLVisualizer viewer("harris viewer");

viewer.addPointCloud(cloud, "original cloud");

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> keypoints_color_handler(cloud, 0, 255, 0);

viewer.addPointCloud(keypoints, keypoints_color_handler, "keypoints");

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 5, "keypoints");

while (!viewer.wasStopped()) {

viewer.spinOnce();

}

return 0;

}

输出:original cloud size: 41049 Detected 60 points!

效果:

3.3.4 SIFT-keypoint

SIFTKeypoint是多2D的sift算法的一个扩展。(注意里面用的是 pcl::PointNormal)

#include <iostream>

#include <pcl/io/pcd_io.h>

#include <pcl/keypoints/sift_keypoint.h> // SIFT

#include <pcl/visualization/pcl_visualizer.h>

// 用于计算分辨率(实现去看3.3.2中的同名函数,一模一样)

double computeCloudResolution(const pcl::PointCloud<pcl::PointXYZ>::ConstPtr &cloud) {}

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>);

pcl::io::loadPCDFile("./table_scene_lms400_downsampled.pcd", *cloud);

std::cout << "original cloud size: " << cloud->size() << std::endl;

double resolution = computeCloudResolution(cloud); // 模型分辨率

// 法向量

pcl::NormalEstimation<pcl::PointXYZ, pcl::PointNormal> ne;

pcl::PointCloud<pcl::PointNormal>::Ptr cloud_normals(new pcl::PointCloud<pcl::PointNormal>());

pcl::search::KdTree<pcl::PointXYZ>::Ptr tree_n(new pcl::search::KdTree<pcl::PointXYZ>());

ne.setInputCloud(cloud);

ne.setSearchMethod(tree_n);

//ne.setRadiusSearch(10 * resolution);

ne.setKSearch(50);

ne.compute(*cloud_normals);

// 拷贝数据

for (size_t i = 0; i < cloud_normals->points.size(); ++i) {

cloud_normals->points[i].x = cloud->points[i].x;

cloud_normals->points[i].y = cloud->points[i].y;

cloud_normals->points[i].z = cloud->points[i].z;

}

// sift参数

const float min_scale = 0.001f;

const int n_octaves = 5; // 3

const int n_scales_per_octave = 6; // 4

const float min_contrast = 0.001f;

// 使用法向量作为强度计算关键点,还可以是rgb、z值或者自定义,具体就要去看API了

pcl::SIFTKeypoint<pcl::PointNormal, pcl::PointXYZ> sift; // pcl::PointXYZ还可以是pcl::PointWithScale包含尺度信息

pcl::PointCloud<pcl::PointXYZ>::Ptr keyspoints(new pcl::PointCloud<pcl::PointXYZ>());

// 注意这里面的类型是 pcl::PointNormal

pcl::search::KdTree<pcl::PointNormal>::Ptr tree(new pcl::search::KdTree<pcl::PointNormal>());

sift.setSearchMethod(tree);

sift.setScales(min_scale, n_octaves, n_scales_per_octave);

sift.setMinimumContrast(min_contrast);

sift.setInputCloud(cloud_normals);

sift.compute(*keyspoints);

std::cout << "No of SIFT points in the result are " << keyspoints->points.size() << std::endl;

pcl::visualization::PCLVisualizer viewer("SIFT Viewer");

viewer.addPointCloud(cloud); // 原始点云

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> keyspoints_color_handler(keyspoints, 0, 255, 0);

viewer.addPointCloud(keyspoints, keyspoints_color_handler, "keypoints"); // 关键点的点云

viewer.setPointCloudRenderingProperties(pcl::visualization::PCL_VISUALIZER_POINT_SIZE, 5, "keypoints");

while (!viewer.wasStopped()) {

viewer.spinOnce();

}

return 0;

}

输出:original cloud size: 41049 No of SIFT points in the result are 2401

效果:

3.4 RANSAC- 随机采样一致性(平面,球体等)

==RANSAC概念及作用==:

- RANSAC是“==RANdom SAmple Consensus==”(随机抽样共识或采样一致性)的缩写,它是一种迭代方法,用于从包含异常值的一组数据中估计数学模型的参数。该算法由Fischler和Bolles于1981年发布。

- RANSANC算法假定要查看的所有数据均由内部值和异常值组成,可以用带有一组特定参数值的模型来解释离群值,而离群值在任何情况下都不适合该模型,其过程可以从数据中估计所选模型的最佳参数。

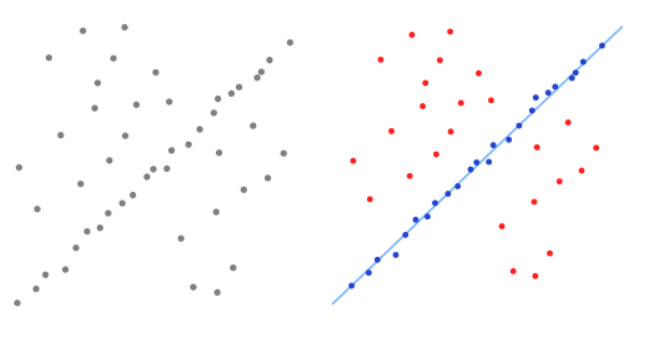

- 下面是RANSAC算法在二维数据集上的简单应用,左边是包含内部值好异常值的数据集的可视表示;右边是以红色显示所有异常值,以蓝色显示内部值。蓝线是RANSAC完成的工作结果,可以看出尝试拟合数据的模型是一条直线,是比较合适的。

==RANSAC算法简介==:

- RANSAC从样本中随机抽选出一个样本子集,使用最小方差估计算法对这个子集计算模型参数,然后计算所有样本与该模型的偏差,再使用一个预先设定好的阈值与偏差比较,当偏差小于阈值时,该样本点属于模型内样本点 ( inliers),或称内部点、局内点或内点,否则为模型外样本点(outliers),或称外部点、局外点或外点,记录下当前的 inliers 的个数,然后重复这一过程。每一次重复都记录当前最佳的模型参数,所谓最佳即是inliers的个数最多 ,此时对应的inliers个数为 best_ninliers 。 每次迭代的末尾都会根据期望的误差率、 best_ninliers、总样本个数、当前迭代次数,计算一 个迭代结束评判因子,据此决定是否迭代结束。迭代结束后,最佳模型参数就是最终的模型参数估计值

- RANSAC理论上可以剔除outliers的影响,并得到全局最优的参数估计。但是RANSAC 有两个问题,首先在每次迭代中都要区分 inliers 和 outlieres,因此需要事先设定阈值,当模型具有明显的物理意义时,这个阈值还比较容易设定,但是若模型比较抽象时,阈值就不那么容易设定了。而且固定阈值不适用于样本动态变化的应用;第二个问题是,RANSAC的迭代次数是运行期决定的,不能预知迭代的确切次数(当然迭代次数的范围是可以预测的)。除此之外, RANSAC 只能从一个特定数据集中估计一个模型。

代码:

#include <iostream>

#include <thread>

#include <pcl/io/pcd_io.h>

#include <pcl/point_types.h>

#include <pcl/console/parse.h>

// 其它形状模型,就先去试试看对应的头文件

#include <pcl/sample_consensus/ransac.h>

#include <pcl/sample_consensus/sac_model_sphere.h> // 球体模型

#include <pcl/sample_consensus/sac_model_plane.h> // 平面模型

#include <pcl/visualization/pcl_visualizer.h>

/*

- 使用方法:

* random_sample_consensus 创建包含外部点的平面

* random_sample_consensus -f 创建包含外部点的平面,并计算平面内部点

*

* random_sample_consensus -s 创建包含外部点的球体

* random_sample_consensus -sf 创建包含外部点的球体,并计算球体内部点

*/

int main(int argc, char* argv[]) {

pcl::PointCloud<pcl::PointXYZ>::Ptr cloud(new pcl::PointCloud<pcl::PointXYZ>());

pcl::PointCloud<pcl::PointXYZ>::Ptr final_cloud(new pcl::PointCloud<pcl::PointXYZ>());

// 给点云填充数据

cloud->width = 500;

cloud->height = 1; //无序点云

cloud->is_dense = false;

cloud->points.resize(cloud->width * cloud->height);

for (size_t i = 0; i < cloud->points.size(); ++i) {

pcl::PointXYZ &point = cloud->points.at(i);

if (pcl::console::find_argument(argc, argv, "-s") >= 0 || pcl::console::find_argument(argc, argv, "-sf") >= 0) {

/*

1 * rand() / (RAND_MAX + 1.0) 只能得到0~1之间的数

2 * rand() / (RAND_MAX + 1.0) 得到0~2之间的数

再减去1就是为了得到 -1.0~1.0之间的数

*/

point.x = 2 * rand() / (RAND_MAX + 1.0) - 1.0;

point.y = 2 * rand() / (RAND_MAX + 1.0) - 1.0;

// 根据 x^2+y^2+z^2=1,来设置球的点云数据

if (i % 5 == 0) // 可能散落在球体外

point.z = 2 * rand() / (RAND_MAX + 1.0) - 1.0;

else if (i % 2 == 0) // 在球体正方向内

point.z = sqrt(1 - pow(point.x, 2) - pow(point.y, 2));

else // 在球体负方向内

point.z = -sqrt(1 - pow(point.x, 2) - pow(point.y, 2));

}

else {